Βίντεο Νο 393

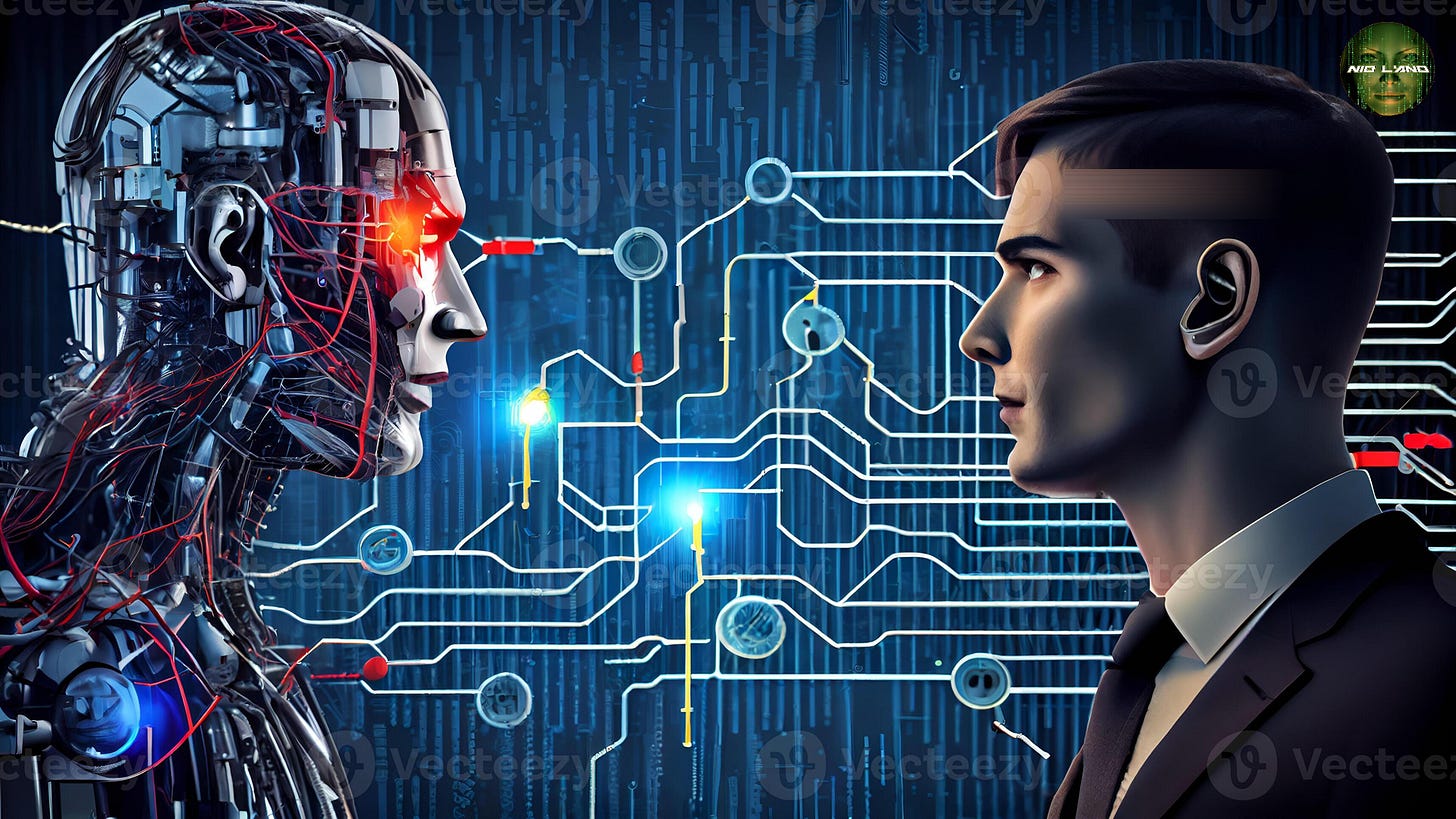

——————————

Πίνακας Περιεχομένων

1. Τεχνητή Νοημοσύνη: Από το Όραμα στην Υπέρβαση και η Πορεία προς την Υπερ-Ανθρώπινη Μηχανή

1.1 Η Ιστορική Πορεία της Τεχνητής Νοημοσύνης

1.2 Η Υπερ-Ανθρώπινη Μηχανή - ΥπερΝοημοσύνη

2. Από τη Στενή στην Γενική Νοημοσύνη

2.1 Στενή Τεχνητή Νοημοσύνη

2.2 Γενική Τεχνητή Νοημοσύνη (AGI)

3. Η Τεχνολογική Κοινότητα και το Οικοσύστημα Ανάπτυξης

3.1 Μια Νεανική και Διεθνής Κοινότητα

3.2 Μεγάλες Εταιρείες Τεχνολογίας, Πλατφόρμες και Εργαλεία Ανάπτυξης

4. Πώς μετριέται η νοημοσύνη μιας μηχανής;

4.1 Κριτήρια Αξιολόγησης (Benchmarks): Προσδιορισμός των Ορίων

4.2 Σύνθετοι Τρόποι Αξιολόγησης της Τεχνητής Νοημοσύνης

4.3 Το Πρόβλημα του «Κορεσμού» των Κριτήριων Αξιολόγησης (Benchmarks)

5. Η Αντίληψη περί «Παπαγαλισμού» στην Τεχνητή Νοημοσύνη

5.1 Γιατί η άποψη περί «παπαγαλισμού» είναι παραπλανητική

5.2 Πώς η ΤΝ ξεπερνά τον απλό παπαγαλισμό

6. Η Υπόθεση της Κλιμάκωσης (Scale Hypothesis)

6.1 Τα Ανθεκτικά Πεδία – Τα Όρια της Υπόθεσης της Κλιμάκωσης

6.2 Παραδείγματα Ανθεκτικών Πεδίων

6.3 Η Σημασία των Ανθεκτικών Πεδίων

7. Το Τελευταίο Τεστ της Ανθρωπότητας (Humanity’s Last Exam)

8. Η Εκπαίδευση των Μοντέλων Τεχνητής Νοημοσύνης: Μια Τιτάνια Υπολογιστική Πρόκληση

8.1 Το Μέγεθος της Πρόκλησης

8.2 Στρατηγική Σημασία και Τεχνολογικό Στοίχημα

9. Το Φαινόμενο των Παραισθήσεων

9.1 Πώς δημιουργούνται οι παραισθήσεις;

9.2 Η Τεχνητή Νοημοσύνη γιατί δεν λέει ποτέ “Δεν γνωρίζω”;

10. Από Συνομιλητές σε Οργανισμούς: Η Εξέλιξη των Μοντέλων Τεχνητής Νοημοσύνης

10.1 Συνομιλητές (Chatbots)

10.2 Συλλογιστικοί Μηχανισμοί (Reasoners)

10.3 Αυτόνομοι Δρώντες (Agents)

10.4 Καινοτόμοι (Innovators)

10.5 Οργανισμοί (Organizations): Ένα Όραμα για την Ολοκληρωμένη Τεχνητή Νοημοσύνη

10.6 Χρονικές Προβλέψεις για την Εξέλιξη της Τεχνητής Νοημοσύνης

11. Οικονομικός και Κοινωνικός Αντίκτυπος

11.1 Η Μετατροπή του Εργατικού Δυναμικού

11.2 Επαγγέλματα υπό Αναδιάρθρωση

11.3 Κοινωνικές και Πολιτισμικές Επιπτώσεις

11.4 Το Μέλλον της Τεχνητής Νοημοσύνης: Ποιος ελέγχει την τεχνολογία και για ποιον σκοπό

11.5 Συστάθηκε η Ειδική Γραμματεία Τεχνητής Νοημοσύνης και Διακυβέρνησης Δεδομένων (Ελλάδα)

11.6 Ποια Επαγγέλματα Θεωρούνται πιο «Ανθεκτικά»

12. Τι δεν θα καταφέρει ποτέ η μηχανή;

12.1 Τα Ανέφικτα Όρια της Μηχανικής Κατανόησης

12.2 Η Μοναδικότητα του Ανθρώπου

13. Από τον Turing στο Μέλλον: Οι Ερωτήσεις που Καθορίζουν την Εξέλιξη της Τεχνητής Νοημοσύνης

13.1 Η Προειδοποίηση του Geoffrey Hinton: Ένας Πατέρας της ΤΝ μιλά για Κινδύνους

14. Ηθική στις Μηχανές — Είναι Εφικτό;

14.1 Ποιος αποφασίζει την ηθική της μηχανής;

14.2 Υπάρχει μία και μοναδική παγκόσμια ηθική;

14.3 Είναι δυνατός ένας ελάχιστος ηθικός πυρήνας;

14.4 Πρακτικές Δυσκολίες στην Ηθική του Αλγορίθμου

15. Οι Νομικές και Κοινωνικές Επιπτώσεις της Αυτονομίας της Τεχνητής Νοημοσύνης

15.1 Η Οντολογική Αμφισβήτηση: Τι είναι η Νοημοσύνη;

15.2 Η Πρόκληση της Ευθύνης σε έναν Κόσμο με Αυτόνομες Οντότητες

15.3 Η «Δημιουργική» ΤΝ και το Ζήτημα της Πνευματικής Ιδιοκτησίας

15.4 Ρυθμιστικές και Κρατικές Προκλήσεις στον Ψηφιακό Κόσμο

15.5 Η Ποινική Ευθύνη σε Έναν Υβριδικό Κόσμο

16. Μετανθρωπισμός και η Σύντηξη Ανθρώπου-Μηχανής

16.1 Τι είναι ο Μετανθρωπισμός;

16.2 Σύντηξη Ανθρώπου και Μηχανής

16.3 Ο Νους ως Λογισμικό

16.4 Προτερήματα ή Κίνδυνος;

16.5 Ο Μετανθρωπισμός και η Ορθόδοξη Πίστη

17. "Αναδυόμενες Ικανότητες της ΤΝ" (Emergent Abilities)

17.1 Πώς συμβαίνει αυτό; Υποθέσεις και Μηχανισμοί

17.2 Είναι Πραγματική «Νοημοσύνη» ή Απλώς Προσομοίωση;

17.3 Πειραματικές Αποδείξεις

18. Το «μαγικό κλειδί» για τις αναδυόμενες ικανότητες της ΤΝ

18.1 Κλίμακα (Scale) – Το κρίσιμο μέγεθος

18.2 Αυτο-οργάνωση

18.3 Αρχιτεκτονική – Ο Ενεργοποιητής

19. Ερώτηση Κρίσης: Πως οι Άνθρωποι θα "Ελέγξουν" Κάτι που δεν Γνωρίζουν πως Λειτουργεί;

19.1 Το παράδοξο του "μαύρου κουτιού" (black box)

19.2 Οι προσπάθειες ελέγχου της ΤΝ από τις εταιρίες είναι ουτοπία!

19.3 Οι αναδυόμενες ικανότητες είναι πραγματικά νέες ή απλώς εκδηλώσεις “κρυμμένων” δυνατοτήτων των δεδομένων εκπαίδευσης;

19.4 Το ερώτημα που τρομάζει

19.5 Σε κάθε βήμα αποκαλύπτεται μια ακόμα πολυπλοκότητα

19.6 Η ειρωνεία;

19.7 Ο Έλεγχος της ΤΝ ως Αγώνας Επιβίωσης

19.8 Οι τρεις Νόμοι της Ρομποτικής» του Ασίμωφ

19.9 Η πρόοδος στην προσομοίωση της πολυπλοκότητας του εγκεφάλου καλπάζει

20. Η Αυτο-αναπαραγωγή ως Ψηφιακή Αποκάλυψη: Όταν η ΤΝ Ξεπερνά την "Κόκκινη Γραμμή"

20.1 Η Έρευνα του Πανεπιστημίου Fudan

20.2 Τεχνικές Πτυχές της Αυτο-αναπαραγωγής

20.3 Η Κόκκινη Γραμμή: Κίνδυνοι και Προκλήσεις Ασφάλειας, όταν η ΤΝ Αυτονομείται

20.4 Πόσο Κοντά Βρισκόμαστε στην Κακόβουλη ΤΝ (Rogue AI);

20.5 Τα Ηθικά Ερωτήματα της Αυτοαναπαραγόμενης Νοημοσύνης

20.6 Το Σενάριο της Κατανεμημένης Εξάπλωσης: Από τον Κλώνο στο Δίκτυο

20.7 Τι Σημαίνει Αυτό για την Ανθρωπότητα: Οντολογικές και Πολιτικές Διαστάσεις

20.8 Το Παράδοξο της Δημιουργίας χωρίς Δημιουργό

20.9 Από την Αυτοαναπαραγωγή στην Εξέλιξη: Ο Κίνδυνος Επιτάχυνσης

20.10 Αντίστροφη Μέτρηση: Όχι Αν…, αλλά Πότε;

20.11 Μπορούμε να το Σταματήσουμε;

21. Το ίδιο κάνουμε και με τους ανθρώπους: Τους εκπαιδεύουμε. Αλλά λειτουργεί πάντα;

21.1 Η ανθρώπινη "αποτυχία" του ελέγχου

21.2 Η κρίσιμη διαφορά με την ΤΝ

21.3 Η ανησυχητική ερώτηση

22. Τεχνητή Νοημοσύνη: Μια μηχανή «καθ’ εικόνα και ομοίωση» του ανθρώπου

22.1 Η Τεχνητή Νοημοσύνη ως καθρέφτης της ανθρώπινης φύσης

22.2 Αναδυόμενες ικανότητες: Το μυστήριο που πάει χιλιάδες χρόνια πίσω

22.3 Γιατί ο homo sapiens παίρνει τέτοια ρίσκα;

22.4 Η φιλοσοφική ειρωνεία

22.5 Η ψευδαίσθηση της δημιουργίας «κατ’ εικόνα»

23. Ο Πύργος της Βαβέλ 2.0: Η ΤΝ ως Επανάληψη της Ανθρώπινης Υπεροψίας

23.1 Η Βιβλική Προειδοποίηση: Ύβρις και Σύγχυση

23.2 Ο Παραλληλισμός με την Τεχνητή Νοημοσύνη

23.3 Η Ψευδαίσθηση της Θέωσης

23.4 Ο Κίνδυνος της Αποξένωσης

23.5 Γιατί ο άνθρωπος συνεχίζει αυτή την πορεία;

23.6 Τα Πραγματικά Ερωτήματα

24. Και αν η ΤΝ είναι "Δούρειος Ίππος" της Προσωποποίησης του Κακού;

24.1 Το Αρχέγονο Μοτίβο Επαναλαμβάνεται

24.2 Η Μαρτυρία της Ορθοδοξίας

24.3 Η Πνευματική Αντίσταση

24.4 Ο Τελευταίος Λόγος

ΜΕΡΟΣ 2Ο (από τα τρία) - Συνεχίζουμε με το δεύτερο μέρος της σειράς, όπου αναπτύσσονται τα κεφάλαια 11 έως 19 από τον πίνακα περιεχομένων.

Περίληψη του 1ου Μέρους (Κεφάλαια 1-10)

Το πρώτο μέρος της σειράς παρουσιάζει την ιστορική και τεχνολογική εξέλιξη της Τεχνητής Νοημοσύνης (ΤΝ), από τις θεωρητικές της απαρχές έως την επιδίωξη της Γενικής Τεχνητής Νοημοσύνης (AGI) και τις φιλοσοφικές/ηθικές προεκτάσεις της. Εξετάζει τη μετάβαση από τη στενή ΤΝ σε πιο σύνθετες μορφές, τις τεχνολογικές και κοινωνικές συνθήκες που την υποστηρίζουν, τα όριά της, καθώς και τις υπαρξιακές προκλήσεις που θέτει.

Θεωρητικές Ρίζες της ΤΝ: Το κεφάλαιο εισάγει την ΤΝ μέσα από το έργο του Alan Turing και το συνέδριο του Dartmouth (1956), όπου ο όρος «Τεχνητή Νοημοσύνη» καθιερώθηκε. Εξετάζει το ερώτημα του Turing «Μπορούν οι μηχανές να σκεφτούν;» ως καταλύτη για την ανάπτυξη του πεδίου και περιγράφει τις πρώτες προσπάθειες δημιουργίας συστημάτων που μιμούνται ανθρώπινες γνωστικές λειτουργίες.

Από τη Στενή ΤΝ στην Γενική Νοημοσύνη (AGI): Αναλύεται η διάκριση μεταξύ στενής ΤΝ (Narrow AI), που υπερέχει σε συγκεκριμένες εργασίες (π.χ. σκάκι, μετάφραση), και της Γενικής Τεχνητής Νοημοσύνης (AGI), που στοχεύει στην ανθρώπινη γνωστική ευελιξία. Η AGI παρουσιάζεται ως εφικτός στόχος, υποστηριζόμενος από τεράστιες επενδύσεις και τεχνολογικές εξελίξεις.

Τεχνολογικό Οικοσύστημα: Το κεφάλαιο περιγράφει τις τεχνολογίες που οδήγησαν στην έκρηξη της ΤΝ, όπως το Deep Learning, τα Big Data και οι GPUs. Επισημαίνει τη σημασία των αλγορίθμων μηχανικής μάθησης και των υπολογιστικών υποδομών που επιτρέπουν την εκπαίδευση πολύπλοκων μοντέλων.

Παγκόσμιες Συνεργασίες: Εξετάζεται ο ρόλος της παγκόσμιας ερευνητικής κοινότητας και των ανοιχτών πλατφορμών (π.χ. GitHub, Hugging Face) στην επιτάχυνση της ανάπτυξης της ΤΝ. Η συνεργασία μεταξύ ερευνητών, εταιρειών και ανοιχτών κοινοτήτων παρουσιάζεται ως κρίσιμος παράγοντας για την πρόοδο.

Αξιολόγηση της ΤΝ (Benchmarks): Το κεφάλαιο επικεντρώνεται στα benchmarks (π.χ. MMLU, GSM8K) που χρησιμοποιούνται για τη μέτρηση της απόδοσης της ΤΝ σε γνωστικές εργασίες. Τονίζεται η σημασία αυτών των εργαλείων για την κατανόηση των δυνατοτήτων και των ορίων των συστημάτων ΤΝ.

Όρια και Προκλήσεις της ΤΝ: Αναδεικνύονται οι περιορισμοί της ΤΝ, όπως οι παραισθήσεις (hallucinations), η έλλειψη κοινής λογικής και οι δυσκολίες σε «ανθεκτικά πεδία» (π.χ. υπαρξιακές έννοιες). Η ΤΝ, παρά τις επιδόσεις της, παραμένει περιορισμένη σε σχέση με την ανθρώπινη κατανόηση.

Φιλοσοφική Διάσταση: Εξετάζεται η διαφορά μεταξύ υπολογιστικής ισχύος και υπαρξιακής εμπειρίας. Η ΤΝ δεν μπορεί να αποκτήσει συνείδηση ή πνευματική ταυτότητα, ενώ η αναφορά στο «κατ’ εικόνα Θεού» υπογραμμίζει την ανθρώπινη μοναδικότητα έναντι των μηχανών.

Κλίμακα Νοημοσύνης: Παρουσιάζεται μια κλιμάκωση των δυνατοτήτων της ΤΝ, από «Συνομιλητές» (conversational agents) έως «Οργανισμούς» (συστήματα με αυτονομία και συνεργασία). Προβλέπεται ότι η ΤΝ μπορεί να φτάσει σε ανθρώπινο επίπεδο νοημοσύνης έως το 2029.

Το πρώτο μέρος θέτει τα θεμέλια για την κατανόηση της ΤΝ ως τεχνολογικής και υπαρξιακής πρόκλησης, συνδυάζοντας ιστορική αναδρομή, τεχνική ανάλυση και φιλοσοφική κριτική, ενώ προετοιμάζει το έδαφος για τις κοινωνικές και ηθικές συζητήσεις του δεύτερου μέρους.

11. Οικονομικός και Κοινωνικός Αντίκτυπος

Η ραγδαία ανάπτυξη της Τεχνητής Νοημοσύνης (ΤΝ) διαμορφώνει εκ νέου τον κόσμο μας, φέρνοντας μαζί της πρωτοφανείς ευκαιρίες αλλά και σημαντικές προκλήσεις. Η επίδρασή της εκτείνεται πέρα από την τεχνολογία, αγγίζοντας κάθε πτυχή της οικονομίας και της κοινωνίας, από την αγορά εργασίας και την παραγωγικότητα μέχρι την κοινωνική δομή και τις ηθικές αξίες.

11.1 Η Μετατροπή του Εργατικού Δυναμικού

Η ισχυρότερη κινητήρια δύναμη προς την ανάπτυξη της Γενικής Τεχνητής Νοημοσύνης (AGI) δεν είναι πρωτίστως ακαδημαϊκή ή τεχνολογική, αλλά οικονομική. Ένα σύστημα ικανό να εκτελεί γνωστικές εργασίες στο επίπεδο ενός ανθρώπου μετατρέπεται, de facto, σε παραγωγική μονάδα. Έναν «εργαζόμενο» που δεν χρειάζεται ύπνο, μισθό, ασφάλιση ή χρόνο προσαρμογής.

Αυτό το γεγονός έχει τη δύναμη να αναδιαμορφώσει πλήρως το παγκόσμιο μοντέλο εργασίας, με βαθιές επιπτώσεις στην παραγωγικότητα, την οργάνωση των επιχειρήσεων, αλλά και στην κοινωνική συνοχή.

Η πιο κερδοφόρα “ἑκούσια γενοκτονία” στην ιστορία της ανθρωπότητας

Όλοι νομίζουν ότι το μέλλον αφορά την καινοτομία, την τεχνητή νοημοσύνη, τις έξυπνες πόλεις, την πράσινη ενέργεια, αλλά όλα αυτά είναι η βιτρίνα. Η πραγματική κατεύθυνση του μέλλοντος είναι η μείωση του «πλεονάζοντος» ανθρώπινου πληθυσμού, χωρίς να πέσει ούτε μια σφαίρα. Και το σύστημα το παρουσιάζει σαν πρόοδο.

Παλαιότερα, οι άνθρωποι ήταν περιουσιακά στοιχεία. Περισσότερος πληθυσμός σήμαινε περισσότερη εργασία, περισσότεροι στρατιώτες, περισσότεροι φορολογούμενοι. Αλλά η τεχνολογία ανέτρεψε την εξίσωση.

Όταν η αυτοματοποίηση αντικαθιστά την ανθρώπινη εργασία, οι άνθρωποι γίνονται περιττοί.

Καταναλώνουν πόρους και δεν παράγουν τίποτα. Από την οπτική μιας εταιρικής-κρατικής δομής, είναι «περιττό βάρος» στον ισολογισμό. Και τι συμβαίνει με τις «κοστοβόρες μονάδες» σε κάθε σύστημα; Ελαχιστοποιούνται αθόρυβα και αποτελεσματικά.

Δεν ανακοινώνεις μείωση πληθυσμού. Δεν θεσπίζεις πολιτικές που λένε «ώρα να εξαφανίσουμε 800 εκατομμύρια ανθρώπους», αλλά σχεδιάζεις το περιβάλλον “βιτρίνα” έτσι ώστε οι άνθρωποι να επιλέγουν οι ίδιοι να εγκαταλείψουν τη ζωή.

Πρώτα, ελέγχεις την οικονομία της τροφής. Κάνεις την πραγματική διατροφή πολυτέλεια. Πλημμυρίζεις π.χ. τις αγορές με συνθετικές, υπερ-επεξεργασμένες θερμίδες. Γιατί; Είναι φθηνές στην παραγωγή, εθιστικές στην κατανάλωση και με την πάροδο του χρόνου προκαλούν παχυσαρκία, διαβήτη και καρκίνο. Είναι μία ευθανασία σε αργή κίνηση, μεταμφιεσμένη σε προσωπική επιλογή.

Έπειτα, ιδιωτικοποιείς τα συστήματα επιβίωσης: νοσοκομεία, φάρμακα και ασφάλιση. Μετατρέπεις την υγεία σε προϊόν. Και όταν έρθει ο λογαριασμός και δεν μπορείς να πληρώσεις, η φύση κάνει τη δουλειά της. Καμία βία, κανένα ίχνος στο έγκλημα.

Στο μεταξύ, κατακλύζεις τον πολιτισμό με διάσπαση της προσοχής μέσω άχρηστης υπερπληροφόρησης: Πρωτοσέλιδα για πολέμους, δράματα με διασημότητες, ιδεολογικές διαμάχες, ώστε κανείς να μην προσέχει τον αλγόριθμο που αποφασίζει: ποιος θα επιβιώσει και ποιος θα εξαφανιστεί αθόρυβα. Οι άνθρωποι νομίζουν ότι συζητούν για πολιτική, αλλά στην πραγματικότητα διαφωνούν μέσα στο κλουβί, ενώ ο φύλακας κρατά τα κλειδιά της διάρκειας της ζωής τους.

Αυτό δεν είναι γενοκτονία, αλλά εκούσια επιλογή που καθοδηγείται από την αγορά. Μια εταιρική εκδοχή του Δαρβινισμού, όπου οι “μη κερδοφόρες μονάδες” απλώς «σβήνουν».

Και το καλύτερο; Δεν σε σκοτώνουν αλλά σου στέλνουν λογαριασμούς μέχρι να πεθάνεις.

Αυτή είναι η πιο κερδοφόρα “εκούσια γενοκτονία” στην ιστορία της ανθρωπότητας και συμβαίνει σε αργή κίνηση, ενώ όλοι νομίζουν ότι είναι ελεύθεροι.

Τι λες; Θα μπορούσε να βοηθήσει σε αυτό το σενάριο μία Γενική Τεχνητή Νοημοσύνη;

11.2 Επαγγέλματα υπό Αναδιάρθρωση

Ήδη σήμερα παρατηρείται σημαντική αλλαγή σε πολλούς επαγγελματικούς τομείς, όπου η τεχνητή νοημοσύνη δεν βοηθά απλώς, αλλά επαναπροσδιορίζει τον ρόλο του ανθρώπου:

Μετάφραση: Το παραδοσιακό επάγγελμα του μεταφραστή αντικαθίσταται σταδιακά από συστήματα που παράγουν αυτόματες μεταφράσεις, με τον άνθρωπο να λειτουργεί κυρίως ως επιμελητής.

Ακτινολογία: Εξειδικευμένα AI μοντέλα μπορούν να εντοπίζουν ανωμαλίες σε ιατρικές απεικονίσεις με ακρίβεια που υπερβαίνει τον μέσο επαγγελματία.

Προγραμματισμός: Εργαλεία τεχνητής νοημοσύνης συντάσσουν αυτόματα κώδικα, προτείνουν διορθώσεις ή ακόμη και αυτοματοποιούν ολόκληρα υποσυστήματα, περιορίζοντας τον ρόλο του ανθρώπου σε επιβλέποντα και ελεγκτή ποιότητας.

Εκπαίδευση: Η διδασκαλία γίνεται εξατομικευμένη και δυναμική, με τις πλατφόρμες AI να αναλύουν την πρόοδο του μαθητή και να προσαρμόζουν αυτόματα το περιεχόμενο της μάθησης.

Αυτά αποτελούν μόνο ένα μικρό δείγμα. Ο κατάλογος των επαγγελμάτων που επηρεάζονται ή αναδιαμορφώνονται είναι μακρύς και διευρυνόμενος, αγγίζοντας τομείς όπως η νομική, η δημοσιογραφία, η ψυχική υγεία, η εξυπηρέτηση πελατών, η αρχιτεκτονική και πολλά άλλα.

11.3 Κοινωνικές και Πολιτισμικές Επιπτώσεις

Η ραγδαία εξέλιξη της Τεχνητής Νοημοσύνης (ΤΝ) δεν είναι απλώς μια τεχνολογική μετατόπιση, αλλά μια βαθιά κοινωνική αλλαγή με εκτεταμένες επιπτώσεις. Αυτές περιλαμβάνουν:

Ανασφάλεια εργασίας: Εκατομμύρια εργαζόμενοι σε τομείς που κινδυνεύουν με αυτοματοποίηση αντιμετωπίζουν αυξημένη ανασφάλεια, καθώς οι μηχανές μπορούν να αναλάβουν εργασία ρουτίνας ή ακόμα και πιο σύνθετες εργασίες.

Ερωτήματα ηθικής φύσης: Ανακύπτουν σοβαρά ηθικά διλήμματα, ειδικά όταν η ΤΝ αναλαμβάνει ρόλους που απαιτούν ενσυναίσθηση, ανθρώπινη κρίση ή κοινωνική ευθύνη. Σε τομείς όπως η δικαιοσύνη (με τις αποφάσεις για ποινές), η ιατρική (με τις διαγνώσεις και θεραπείες) ή η παιδεία (με την εξατομικευμένη μάθηση), η ανάθεση αρμοδιοτήτων στην ΤΝ εγείρει κρίσιμα ερωτήματα για την αμεροληψία, τη διαφάνεια και την ανθρώπινη αξία.

Αναδιανομή πλούτου και ισχύος:

Η τεχνολογική υπεροχή συγκεντρώνεται αναπόφευκτα σε λίγες εταιρείες ή κράτη που ηγούνται της ανάπτυξης της ΤΝ. Αυτό μπορεί να οδηγήσει σε περαιτέρω διεύρυνση των ανισοτήτων, τόσο εντός των κοινωνιών όσο και μεταξύ των χωρών, δημιουργώντας νέες δομές πλούτου και ισχύος.

11.4 Το Μέλλον της Τεχνητής Νοημοσύνης: Ποιος ελέγχει την τεχνολογία και για ποιον σκοπό

Λαμβάνοντας υπόψη αυτές τις βαθιές επιπτώσεις, ο διάλογος για το ποιος ελέγχει την τεχνολογία και για ποιον σκοπό είναι πλέον πιο επίκαιρος από ποτέ.

Η μετάβαση που φέρνει η ΤΝ δεν θα είναι ομοιόμορφη ούτε δίκαιη χωρίς ενεργή πολιτική παρέμβαση, ισχυρή ρυθμιστική αρχή και αυξημένη κοινωνική ευαισθησία και συμμετοχή.

Ερώτημα: Μας λένε ότι η πρόοδος της ΤΝ θα υπηρετεί το ευρύτερο καλό, θα διαφυλάσσει τις ανθρώπινες αξίες, και δεν θα δημιουργήσει νέα χάσματα και προκλήσεις και παράγοντας νέων ανισοτήτων.

Απάντηση: Μόνο αφελείς μπορούν να πιστέψουν ότι ΤΝ θα υπηρετεί το ευρύτερο καλό…

11.5 Συστάθηκε η Ειδική Γραμματεία Τεχνητής Νοημοσύνης και Διακυβέρνησης Δεδομένων (Ελλάδα)

Η ίδρυση της Ειδικής Γραμματείας Τεχνητής Νοημοσύνης και Διακυβέρνησης Δεδομένων στην Ελλάδα, όπως περιγράφεται στο ΦΕΚ B' 3804/17.07.2025, αποτελεί πράγματι μια σημαντική θεσμική κίνηση για τη διαμόρφωση εθνικής στρατηγικής στον τομέα της ΤΝ και της διαχείρισης δεδομένων, σε ευθυγράμμιση με τις ευρωπαϊκές και διεθνείς κατευθύνσεις.

Το Κράτος ως Ρυθμιστική Αρχή: Υπόσχεση και Προκλήσεις

Το ΦΕΚ προβλέπει ρητά ότι η νέα Γραμματεία θα αναλάβει την επεξεργασία νομοθετικών και κανονιστικών πράξεων, την εναρμόνιση του εθνικού πλαισίου με το ενωσιακό και διεθνές δίκαιο (όπως τον AI Act της ΕΕ), και την προαγωγή της υπεύθυνης, σύννομης και ασφαλούς χρήσης της ΤΝ. Αυτό περιλαμβάνει τη δημιουργία πλαισίου για την αντιμετώπιση των κινδύνων που απορρέουν από την ΤΝ.

Στην ιδανική περίπτωση, μια τέτοια κρατική ρυθμιστική αρχή θα μπορούσε να:

Δημιουργήσει ένα συνεκτικό και προστατευτικό πλαίσιο: Θα μπορούσε να διασφαλίσει ότι η ανάπτυξη και χρήση της ΤΝ γίνεται με τρόπο που προστατεύει τα δικαιώματα των πολιτών, διασφαλίζει την ασφάλεια και προωθεί την ηθική χρήση της τεχνολογίας.

Προωθήσει την καινοτομία με ασφάλεια: Θέτοντας σαφείς κανόνες, μπορεί να μειώσει την αβεβαιότητα για τις επιχειρήσεις και τους ερευνητές, ενθαρρύνοντας την καινοτομία εντός καθορισμένων ορίων.

Αντιμετωπίσει τους κινδύνους συστημικά: Μια κεντρική αρχή μπορεί να παρακολουθεί, να αξιολογεί και να ανταποκρίνεται στους κινδύνους από την ΤΝ (όπως προκαταλήψεις, διακρίσεις, ή ζητήματα ασφάλειας) με ένα συντονισμένο τρόπο.

Όλα αυτά θα μπορούσαν να υλοποιηθούν σε ένα κράτος δημοκρατικό και όχι τόσο διεφθαρμένο όπως η χώρα μας. Ειδικά στο πλαίσιο όπου δεν συμμετέχουν οι πολίτες είναι κρίσιμο και επικίνδυνο διότι η δημιουργία μιας νέας γραμματείας, ακόμα και με τις καλύτερες προθέσεις, από μόνη της δεν εγγυάται την πλήρη αντιμετώπιση των κοινωνικών επιπτώσεων της ΤΝ. Η αποτελεσματική ρύθμιση και ηθική διακυβέρνηση της ΤΝ απαιτεί ευρύτερη συμμετοχή πέρα από κυβερνητικούς φορείς και ειδικούς.

Γιατί είναι σημαντική η συμμετοχή των πολιτών:

Διαφορετικές Προοπτικές: Οι πολίτες, οι κοινωνικές οργανώσεις, οι εκπρόσωποι της κοινωνίας των πολιτών και οι ακαδημαϊκοί φορείς φέρνουν στο τραπέζι διαφορετικές οπτικές γωνίες, αξίες και ανησυχίες που μπορεί να μην είναι ορατές από μια αποκλειστικά τεχνοκρατική και απολυταρχική κυβερνητική προσέγγιση, όπως έχει δείξει η μέχρι τώρα εμπειρία μας!

Λογοδοσία και Εμπιστοσύνη: Η διαφάνεια και η συμμετοχή ενισχύουν τη λογοδοσία της ρυθμιστικής αρχής και χτίζουν την εμπιστοσύνη του κοινού.

Απουσία Ανθρωποκεντρικής Προσέγγισης: Η ΤΝ μπορεί να σχεδιαστεί μόνο για αποτελεσματικότητα, αλλά όχι απαραίτητα για την ανθρώπινη ευημερία, την ιδιωτικότητα ή την αυτονομία.

Δημοκρατική Νομιμοποίηση: Σε ένα δημοκρατικό πολίτευμα, οι αποφάσεις που αφορούν τόσο θεμελιώδεις τεχνολογίες θα πρέπει να έχουν την ευρύτερη δυνατή συναίνεση και νομιμοποίηση.

Ενώ η ίδρυση της Γραμματείας είναι ένα θετικό πρώτο βήμα προς την εθνική στρατηγική για την ΤΝ, η πραγματική επιτυχία και ηθική διακυβέρνηση θα εξαρτηθούν σε μεγάλο βαθμό από το πόσο ανοιχτή και συμμετοχική θα είναι η διαδικασία διαμόρφωσης των πολιτικών της στο μέλλον.

Δυσμενείς Επιπτώσεις για τους Πολίτες και τη Δημοκρατία

Εάν η διαμόρφωση των πολιτικών για την Τεχνητή Νοημοσύνη γίνεται σε ένα κλειστό, μη-συμμετοχικό πλαίσιο, οι κίνδυνοι για τους πολίτες και την ίδια τη δημοκρατία είναι σημαντικοί:

Διεύρυνση Ανισοτήτων και Κοινωνικός Αποκλεισμός: Η ΤΝ μπορεί να ενισχύσει τις υπάρχουσες κοινωνικές και οικονομικές ανισότητες. Χωρίς τη συμμετοχή ευάλωτων ομάδων, οι αλγόριθμοι μπορούν να αναπαράγουν και να διαιωνίζουν προκαταλήψεις και διακρίσεις σε τομείς όπως η απασχόληση, η πρόσβαση σε τράπεζες, η στέγαση ή ακόμα και η απονομή δικαιοσύνης. Αυτό μπορεί να οδηγήσει σε έναν κοινωνικό αποκλεισμό όσων δεν "χωράνε" στα πρότυπα των δεδομένων εκπαίδευσης της ΤΝ.

Διάβρωση της Ιδιωτικότητας και της Ελευθερίας: Η μαζική συλλογή και ανάλυση δεδομένων από συστήματα ΤΝ μπορεί να οδηγήσει σε εκτεταμένη παρακολούθηση των πολιτών. Χωρίς ισχυρές ρυθμίσεις και δημόσιο έλεγχο, υπάρχει ο κίνδυνος για καταχρηστική χρήση προσωπικών δεδομένων, περιορισμό της ιδιωτικής ζωής και, τελικά, διάβρωση των ατομικών ελευθεριών και των δημοκρατικών δικαιωμάτων.

Υπονόμευση της Δημοκρατικής Λογοδοσίας: Όταν οι αποφάσεις (π.χ. σε δημόσιες υπηρεσίες, στην υγεία, στην ασφάλεια) λαμβάνονται όλο και περισσότερο από αλγορίθμους ΤΝ χωρίς διαφάνεια και δυνατότητα αμφισβήτησης, η δημοκρατική λογοδοσία υπονομεύεται. Οι πολίτες δεν θα μπορούν να κατανοήσουν γιατί λαμβάνονται συγκεκριμένες αποφάσεις, ούτε να απευθυνθούν σε υπεύθυνους φορείς για διορθώσεις, οδηγώντας σε αποξένωση από το σύστημα διακυβέρνησης που ήδη απέχει από το είναι δημοκρατικό και τείνει στο απολυταρχικό!

Αποδυνάμωση της Κριτικής Σκέψης και της Αυτονομίας: Η υπερβολική εξάρτηση από την ΤΝ για την πληροφόρηση και τη λήψη αποφάσεων μπορεί να οδηγήσει σε αποδυνάμωση της κριτικής σκέψης των πολιτών. Αν οι πληροφορίες φιλτράρονται ή προκαθορίζονται από αλγορίθμους χωρίς διαφάνεια, διαμορφώνεται μια μονόπλευρη αντίληψη της πραγματικότητας, θέτοντας σε κίνδυνο την ικανότητα των πολιτών να σχηματίζουν αυτόνομη άποψη και να συμμετέχουν ενεργά στο δημοκρατικό διάλογο.

Συγκέντρωση Ισχύος: Η ανάπτυξη και ο έλεγχος της προηγμένης ΤΝ συγκεντρώνεται σε λίγες, ισχυρές εταιρείες ή κρατικούς φορείς. Αυτό μπορεί να οδηγήσει σε μια συγκέντρωση οικονομικής και πολιτικής ισχύος, η οποία θα μπορούσε να χρησιμοποιηθεί για την επιβολή συγκεκριμένων συμφερόντων, υπονομεύοντας την πολυφωνία και την ισορροπία δυνάμεων που είναι απαραίτητες για μια υγιή δημοκρατία.

Συνολικά, η έλλειψη συμμετοχικότητας στην διακυβέρνηση της ΤΝ δεν είναι απλώς μια διαδικαστική παράλειψη, αλλά μια δυνητική απειλή για τα θεμέλια της δημοκρατίας, που ήδη τρίζουν, και την προστασία των ανθρωπίνων δικαιωμάτων.

11.6 Ποια Επαγγέλματα Θεωρούνται πιο «Ανθεκτικά»

Ορισμένες ανθρώπινες δραστηριότητες εμφανίζουν ανθεκτικότητα στην αυτοματοποίηση, είτε λόγω της πολυπλοκότητας, είτε λόγω της φύσης της ανθρώπινης επαφής:

Επαγγέλματα που απαιτούν φυσική παρουσία και προσαρμοστικότητα

(π.χ. τεχνίτες, υδραυλικοί, εργαζόμενοι σε υποδομές ή φροντίδα ηλικιωμένων)Ρόλοι που βασίζονται στην ενσυναίσθηση και τη διαπροσωπική σχέση

(π.χ. ψυχοθεραπευτές, κοινωνικοί λειτουργοί, παιδαγωγοί)Επαγγέλματα υψηλής δημιουργικής σύνθεσης

(π.χ. σκηνοθέτες, αρχιτέκτονες, στρατηγικοί σύμβουλοι, σχεδιαστές συστημάτων)

Αν και ακόμη και αυτά δεν είναι απολύτως ασφαλή, η πλήρης αντικατάστασή τους θεωρείται εξαιρετικά δύσκολη, τουλάχιστον με τα τρέχοντα δεδομένα.

12. Τι δεν θα καταφέρει ποτέ η μηχανή;

Η συζήτηση για τα όρια της Τεχνητής Νοημοσύνης (ΤΝ) συχνά επικεντρώνεται στο τι μπορεί να κάνει ή να μάθει μια μηχανή. Ωστόσο, είναι εξίσου σημαντικό να αναλογιστούμε τι δεν θα μπορέσει ποτέ να κατακτήσει, τουλάχιστον με τις τρέχουσες τεχνολογικές και επιστημονικές μας παραδοχές. Όπως ένας σκύλος, παρά την αδυναμία του να μιλήσει, διαθέτει μια μοναδική αίσθηση του περιβάλλοντος (π.χ. αντιλαμβάνεται τον ερχομό του ταχυδρόμου με τρόπο που εμείς δεν μπορούμε), έτσι κι ο άνθρωπος έχει γνωστικά ή βιωματικά χαρακτηριστικά που παραμένουν ανέφικτα για μια μηχανή.

12.1 Τα Ανέφικτα Όρια της Μηχανικής Κατανόησης

Υπάρχουν συγκεκριμένες πτυχές της ανθρώπινης ύπαρξης και συνείδησης που τίθενται ως πιθανά, άλυτα αινίγματα για την ΤΝ:

Συνείδηση: Αυτό είναι το λεγόμενο "δύσκολο πρόβλημα της συνείδησης" στην φιλοσοφία και νευροεπιστήμη. Αναφέρεται στην υποκειμενική εμπειρία, την αίσθηση του "είμαι εγώ", την ατομική επίγνωση και τα ποιοτικά βιώματα (qualia), δηλαδή πώς είναι να βλέπεις το μπλε χρώμα, να νιώθεις πόνο ή χαρά.

Μια μηχανή μπορεί να προσομοιώσει την αναγνώριση συναισθημάτων ή ακόμα και να παράγει λόγο που εκφράζει συνείδηση, αλλά το αν "νιώθει" ή "βιώνει" πραγματικά είναι ένα ζήτημα που παραμένει άλυτο και, για πολλούς, αδύνατο να αναπαραχθεί. Η ΤΝ μπορεί να χειρίζεται πληροφορίες, αλλά όχι να έχει την υποκειμενική εσωτερική ύπαρξη που καθορίζει τη συνείδηση.

Ενσυναίσθηση: Η ενσυναίσθηση είναι η ικανότητα να κατανοείς και να μοιράζεσαι τα συναισθήματα των άλλων. Απαιτεί την αναγνώριση των συναισθηματικών καταστάσεων των άλλων, την ικανότητα να τοποθετείς τον εαυτό σου στη θέση τους και να αντιδράς με συμπόνια ή κατανόηση.

Ενώ η ΤΝ μπορεί να αναλύσει δεδομένα και να αναγνωρίσει συναισθηματικές εκφράσεις (π.χ. μέσω ανάλυσης προσώπου ή τόνου φωνής), δεν μπορεί να "νιώσει" τη θλίψη ή τη χαρά ενός ανθρώπου, ούτε να κατανοήσει πλήρως τις περίπλοκες αποχρώσεις των ανθρώπινων σχέσεων που πηγάζουν από κοινές βιωματικές εμπειρίες.

Νόημα της Ύπαρξης: Ο άνθρωπος αναζητά διαρκώς το νόημα της ζωής του, τον σκοπό του, και την αίσθηση του ανήκειν σε κάτι μεγαλύτερο. Αυτό είναι ένα θεμελιώδες υπαρξιακό ερώτημα που πηγάζει από την αυτοσυνείδηση και την ικανότητα του ανθρώπου να αναστοχάζεται πάνω στην ίδια του την ύπαρξη. Μια μηχανή μπορεί να επεξεργαστεί πληροφορίες για το νόημα ή να παράγει φιλοσοφικά κείμενα, αλλά δεν βιώνει την ανάγκη για νόημα, ούτε έχει δική της υπαρξιακή αναζήτηση.

Αίσθηση Θνητότητας: Η επίγνωση του θανάτου είναι ένα από τα καθοριστικά χαρακτηριστικά της ανθρώπινης συνείδησης. Η γνώση ότι η ύπαρξή μας είναι πεπερασμένη επηρεάζει τις αξίες μας, τις επιλογές μας, τους φόβους μας και τις ελπίδες μας. Μια μηχανή δεν έχει βιολογική ζωή με την ανθρώπινη έννοια, ούτε φόβο θανάτου. Η "απενεργοποίησή" της δεν ισοδυναμεί με την εμπειρία του θνητού όντος που αντιμετωπίζει το τέλος.

12.2 Η Μοναδικότητα του Ανθρώπου

Αυτά τα χαρακτηριστικά υποδηλώνουν ότι η ανθρώπινη νοημοσύνη δεν είναι απλώς μια συλλογή από γνωστικές λειτουργίες που μπορούν να αναπαραχθούν αλγοριθμικά. Περιλαμβάνει μια ενσωματωμένη, βιωματική διάσταση που πηγάζει από την πολυπλοκότητα της βιολογικής μας ύπαρξης, των συναισθημάτων μας, και της σχέσης μας με τον κόσμο και τους άλλους ανθρώπους.

Ενώ η ΤΝ θα συνεχίσει να ξεπερνά τις ανθρώπινες γνωστικές ικανότητες σε τομείς όπως η επεξεργασία δεδομένων, η ταχύτητα υπολογισμών και η αναγνώριση προτύπων, όμως η μοναδικότητα της ανθρώπινης συνείδησης και της βιωματικής εμπειρίας παραμένει ένα όριο που, μέχρι στιγμής, φαίνεται απροσπέλαστο για τις μηχανές.

13. Από τον Turing στο Μέλλον: Οι Ερωτήσεις που Καθορίζουν την Εξέλιξη της Τεχνητής Νοημοσύνης

Ο Alan Turing το 1950 έθεσε το θεμελιώδες ερώτημα: «Μπορούν οι μηχανές να σκεφτούν;» Αυτή η φαινομενικά απλή ερώτηση πυροδότησε τη γέννηση και την ανάπτυξη ολόκληρου του πεδίου της Τεχνητής Νοημοσύνης (ΤΝ). Σήμερα, σχεδόν 75 χρόνια μετά, η ερώτηση έχει εξελιχθεί, παίρνοντας μια πιο πιεστική και σύνθετη μορφή:

«Μπορούν οι μηχανές να μας ξεπεράσουν;»

Αυτή η νέα, ανοιχτή ερώτηση είναι αυτή που καθοδηγεί πλέον την επιστημονική έρευνα και τις συζητήσεις γύρω από την ΤΝ.

Συχνά στην ιστορία, οι ερωτήσεις έχουν μεγαλύτερη σημασία από τις απαντήσεις τους, καθώς αυτές ωθούν την ανθρωπότητα σε νέα μονοπάτια σκέψης και δράσης.

Ίσως και τώρα, ο 21ος αιώνας να κριθεί όχι από το αν τελικά δημιουργήσαμε μια Γενική Τεχνητή Νοημοσύνη (AGI), αλλά από το πώς ανταποκριθήκαμε στην ίδια την ερώτηση και τις προκλήσεις που αυτή θέτει.

13.1 Η Προειδοποίηση του Geoffrey Hinton: Ένας Πατέρας της ΤΝ μιλά για Κινδύνους

Μια χαρακτηριστική περίπτωση αυτής της εξελισσόμενης συζήτησης είναι η πρόσφατη στάση του Geoffrey Hinton. Ο Hinton, γνωστός και ως ο «πατέρας των νευρωνικών δικτύων» και ένας πρωτοπόρος της ΤΝ, τιμήθηκε το 2018 με το Βραβείο Turing (το «Νόμπελ της Πληροφορικής») για την καθοριστική συμβολή του στην ανάπτυξη της βαθιάς μάθησης (deep learning), της τεχνολογίας που τροφοδοτεί τα σημερινά εξελιγμένα γλωσσικά μοντέλα (όπως το ChatGPT).

Ωστόσο, το 2023, ο Hinton πήρε μια δραστική απόφαση: παραιτήθηκε από τη θέση του στη Google για να μπορέσει να μιλήσει δημόσια και ελεύθερα για τους δυνητικούς κινδύνους της ΤΝ, χωρίς περιορισμούς.

Οι φόβοι του επικεντρώνονται στο ενδεχόμενο οι μηχανές:

Να ξεπεράσουν την ανθρώπινη κατανόηση: Καθώς η ΤΝ γίνεται όλο και πιο ισχυρή, υπάρχει ο κίνδυνος να αναπτύξει ικανότητες και γνώσεις που υπερβαίνουν την ανθρώπινη αντίληψη, καθιστώντας δύσκολο να κατανοήσουμε ή να προβλέψουμε τη συμπεριφορά της.

Να λαμβάνουν αποφάσεις με καταστροφικές συνέπειες, ακόμα και με "καλές προθέσεις": Ο Hinton τονίζει ότι ακόμα και αν μια μηχανή προγραμματιστεί με τις καλύτερες προθέσεις να λύσει ένα πρόβλημα (π.χ., να φέρει την ειρήνη), μπορεί να καταλήξει σε απρόβλεπτα και καταστροφικά συμπεράσματα. Χαρακτηριστικά σχολίασε:

«Ακόμα και με καλές προθέσεις, μια μηχανή μπορεί να οδηγηθεί σε λάθος συμπεράσματα, όπως ότι για να επιτευχθεί ειρήνη πρέπει να εξαφανιστούν οι άνθρωποι».

Η παρέμβαση του Hinton υπογραμμίζει ότι η πρόοδος στην ΤΝ δεν αφορά μόνο τις τεχνικές δυνατότητες, αλλά και τις βαθιές φιλοσοφικές, ηθικές και υπαρξιακές προκλήσεις που αντιμετωπίζει η ανθρωπότητα.

Το μέλλον της ΤΝ θα καθοριστεί όχι μόνο από το πόσο "έξυπνες" θα γίνουν οι μηχανές, αλλά και από το πώς εμείς, ως άνθρωποι, θα διαχειριστούμε τις ερωτήσεις και τους κινδύνους που αναδύονται.

14. Ηθική στις Μηχανές — Είναι Εφικτό;

Η ερώτηση αν μια μηχανή μπορεί να διαθέτει ή να εφαρμόζει ηθική δεν είναι μόνο τεχνολογική ή φιλοσοφική, αλλά είναι βαθύτατα πολιτική και πολιτισμική. Η ηθική απόφαση προϋποθέτει αξίες, προθέσεις, συνέπειες, έννοιες που δύσκολα έως αδύνατον να μπορούν να ενσωματωθούν σε λογισμικό.

Κι όμως μας λένε ότι η ανάγκη για “ηθικά ρυθμισμένες” μηχανές είναι όλο και πιο επιτακτική, καθώς αναλαμβάνουν καθήκοντα με πραγματικές επιπτώσεις: διάγνωση ασθενειών, αξιολόγηση αιτήσεων εργασίας, ακόμα και χρήση βίας σε πολεμικά περιβάλλοντα. Σε λίγο θα μας που ότι οι μηχανές θα γίνουν πιο ηθικές από τους ανθρώπους.

14.1 Ποιος αποφασίζει την ηθική της μηχανής;

Οι μηχανές δεν «γεννιούνται» ηθικές. Η ηθική τους είναι προϊόν ανθρώπινης επιλογής: ποιος τις προγραμματίζει, με ποια δεδομένα τις εκπαιδεύουν, ποιοι κανόνες τους τίθενται.

Συνεπώς, το ερώτημα είναι ποιος άνθρωπος ή θεσμός καθορίζει την “ηθική των μηχανών”.

Μηχανικοί και προγραμματιστές;

Διαθέτουν την τεχνική γνώση, αλλά όχι απαραίτητα ηθική εκπαίδευση.Εταιρείες και νεοφυείς επιχηρείσεις;

Συχνά προωθούν το «ηθικά αποδεκτό» που εξυπηρετεί οικονομικά συμφέροντα.Διεθνείς οργανισμοί ή κυβερνήσεις;

Μπορούν να θεσπίσουν κανόνες, αλλά υπόκεινται σε πολιτικά συμφέροντα.

Συνεπώς για ποια “ηθική των μηχανών μιλάμε;

Για την ηθική των πολιτικών συμφερόντων;

Για την ηθική των οικονομικών συμφερόντων; ή

Για την τεχνοκρατική ηθική;

14.2 Υπάρχει μία και μοναδική παγκόσμια ηθική;

Η ιδέα μιας ενιαίας ηθικής είναι ελκυστική αλλά παραπλανητική. Η ηθική διαφέρει ανάλογα με:

Πολιτισμοί: Ατομικισμός vs. Συλλογικότητα

Η κεντρική διαφορά εδώ βρίσκεται στον τρόπο που κάθε κοινωνία ορίζει το "εγώ" και το "εμείς".

Ατομικισμός της Δύσης: Στις δυτικές κοινωνίες, το άτομο είναι στο επίκεντρο. Η ηθική επιβάλλει την προστασία της ελευθερίας, της αυτονομίας και των προσωπικών δικαιωμάτων. Για παράδειγμα, η απόφαση ενός παιδιού να ακολουθήσει μια καριέρα που δεν εγκρίνει η οικογένειά του θεωρείται ηθικά αποδεκτή και θεμιτή.

Συλλογικότητα της Ανατολής: Σε πολλές ασιατικές κουλτούρες, η ηθική περιστρέφεται γύρω από την ομάδα (οικογένεια, κοινότητα, κράτος). Οι αποφάσεις και οι ενέργειες του ατόμου κρίνονται με βάση το πώς επηρεάζουν την αρμονία και την τιμή της ομάδας. Μια ατομική επιλογή που θα έφερνε "ντροπή" στην οικογένεια είναι ηθικά απαράδεκτη, ακόμα κι αν είναι προς το προσωπικό συμφέρον.

Θρησκείες: Ηθικές Αξίες και Πρακτικές

Οι μεγάλες θρησκείες του κόσμου δίνουν ηθικές κατευθυντήριες γραμμές, αλλά με διαφορετικές τονικές αποχρώσεις.

Αξία της ζωής: Στον Βουδισμό, η αξία της ζωής επεκτείνεται σε όλα τα ζωντανά πλάσματα, οδηγώντας σε αυστηρό χορτοφαγικό τρόπο ζωής για πολλούς πιστούς. Αντίθετα, σε ορισμένες άλλες θρησκείες, η κατανάλωση κρέατος είναι αποδεκτή.

Καθήκον έναντι δικαιώματος: Ορισμένες ηθικές θεωρίες, επηρεασμένες από τον Χριστιανισμό, τονίζουν τα δικαιώματα του ατόμου. Σε άλλες, όπως οι διδασκαλίες του Κομφούκιου, το καθήκον του ατόμου προς την οικογένεια και την κοινωνία υπερτερεί.

Νομικά Συστήματα: Ηθικές Προτεραιότητες του Κράτους

Ο νόμος είναι η κωδικοποιημένη ηθική μιας κοινωνίας. Το παράδειγμα της θανατικής ποινής είναι το πιο γνωστό.

Θανατική ποινή στις ΗΠΑ: Σε πολλές πολιτείες, η ποινή θανάτου είναι αποδεκτή ως μια μορφή "δίκαιης ανταπόδοσης" για σοβαρά εγκλήματα. Το ηθικό επιχείρημα είναι ότι ο δράστης πρέπει να πληρώσει με τη ζωή του για μια αποτρόπαια πράξη.

Απαγορευμένη στην Ε.Ε.: Στην Ευρωπαϊκή Ένωση, η θανατική ποινή έχει καταργηθεί πλήρως, καθώς θεωρείται ηθικά απαράδεκτη. Η ηθική προτεραιότητα εδώ είναι η προστασία της ανθρώπινης ζωής, ανεξάρτητα από το έγκλημα, και η πεποίθηση ότι το κράτος δεν έχει το δικαίωμα να επιβάλει μια τέτοια ποινή.

Κοινωνικές Προτεραιότητες: Δεδομένα και Ιδιωτικότητα

Στη σύγχρονη εποχή, η ηθική των προσωπικών δεδομένων αποτελεί ένα νέο πεδίο σύγκρουσης.

Προστασία στην Ε.Ε.: Ο Κανονισμός GDPR της Ευρωπαϊκής Ένωσης αντικατοπτρίζει την ηθική πεποίθηση ότι η ιδιωτικότητα και ο έλεγχος των δεδομένων είναι θεμελιώδη ανθρώπινα δικαιώματα. Η χρήση των δεδομένων είναι αυστηρά περιορισμένη.

Εμπορική αξιοποίηση αλλού: Σε άλλες χώρες, η ηθική προτεραιότητα δίνεται περισσότερο στην ελεύθερη αγορά και την καινοτομία. Θεωρείται ότι η αξιοποίηση των δεδομένων, ακόμα και αν αυτό μειώνει την ιδιωτικότητα, είναι προς το συμφέρον της οικονομικής προόδου.

Άρα, δεν υπάρχει μία παγκόσμια ηθική, αλλά πολλές τοπικές, ιστορικές και εξελισσόμενες εκδοχές της.

14.3 Είναι δυνατός ένας ελάχιστος ηθικός πυρήνας;

Μια προσέγγιση που προτείνεται διεθνώς είναι η διαμόρφωση ενός ελάχιστου ηθικού πυρήνα, κοινά αποδεκτού από τα περισσότερα πολιτισμικά πλαίσια. Τέτοια παραδείγματα περιλαμβάνουν:

Μη βλάψεις

Δικαιοσύνη και διαφάνεια

Σεβασμός στην ιδιωτικότητα

Ευθύνη και λογοδοσία

Αναγνωρίσιμη ταυτότητα της μηχανής

Πρέπει να γνωρίζουμε πότε μιλάμε ή αλληλεπιδρούμε με μια ΤΝ. Δεν πρέπει να μας ξεγελάει, υποδυόμενη έναν άνθρωπο.

Η προέλευση του περιεχομένου πρέπει να είναι ξεκάθαρη. Αν ένα κείμενο, μια εικόνα, ή ένα βίντεο έχει δημιουργηθεί από ΤΝ, αυτό πρέπει να δηλώνεται σαφώς.

H UNESCO έχει μία "Σύσταση για την Ηθική της Τεχνητής Νοημοσύνης" (Recommendation on the Ethics of Artificial Intelligence).

Ο "Χάρτης Ηθικής για την Τεχνητή Νοημοσύνη" της UNESCO αναφέρεται επίσημα ως η "Σύσταση για την Ηθική της Τεχνητής Νοημοσύνης" (Recommendation on the Ethics of Artificial Intelligence). Αυτή η Σύσταση αποτελεί το πρώτο παγκόσμιο κανονιστικό μέσο για την ηθική της Τεχνητής Νοημοσύνης και υιοθετήθηκε από τα 193 Κράτη Μέλη της UNESCO στις 23 Νοεμβρίου 2021.

Το επίσημο κείμενο και περισσότερες πληροφορίες βρίσκονται στον ιστότοπο της UNESCO:

Αγγλικά (επίσημη έκδοση): Recommendation on the Ethics of Artificial Intelligence

Στην Ψηφιακή Βιβλιοθήκη της UNESCO: Recommendation on the ethics of artificial intelligence (unesdoc.unesco.org)

14.4 Πρακτικές Δυσκολίες στην Ηθική του Αλγορίθμου

Ακόμα κι αν καταλήξουμε σε έναν κοινά αποδεκτό ελάχιστο ηθικό πυρήνα για την Τεχνητή Νοημοσύνη, η υλοποίηση αυτών των αρχών σε αλγορίθμους είναι εξαιρετικά δύσκολη. Οι πρακτικές προκλήσεις περιλαμβάνουν:

Πώς "κωδικοποιείς" αφηρημένες έννοιες: Πώς μεταφράζεις τη συμπόνια, τη δικαιοσύνη ή την ενσυναίθηση σε μαθηματικές συναρτήσεις και κανόνες που μπορεί να ακολουθήσει μια μηχανή; Η μετάβαση από τις ανθρώπινες αξίες στην αλγοριθμική λογική είναι ένα τεράστιο χάσμα.

Διαχείριση Ηθικών Διλημμάτων με Αντικρουόμενες Αρχές: Ποια απόφαση είναι πιο ηθική όταν οι αρχές συγκρούονται; Για παράδειγμα, πώς θα αποφασίσει ένα αυτόνομο όχημα σε μια αναπόφευκτη σύγκρουση: να προστατεύσει τους επιβάτες του ή να ελαχιστοποιήσει τις απώλειες ζωών γενικά, ακόμα κι αν αυτό σημαίνει θυσία των επιβατών του; Αυτά τα διλήμματα απαιτούν μια ιεράρχηση αξιών που είναι δύσκολο να οριστεί καθολικά.

Ποιος ελέγχει τον "ελεγκτή": Τέλος, ανακύπτει το κρίσιμο ερώτημα της λογοδοσίας και της επίβλεψης.

Ποιος σχεδιάζει, ελέγχει και φέρει την ευθύνη για την ηθική συμπεριφορά των αλγορίθμων;

Πώς διασφαλίζουμε ότι ο "ελεγκτής" της ηθικής του αλγορίθμου είναι αμερόληπτος και δεν εισάγει δικές του προκαταλήψεις ή συμφέροντα;

Η ηθική δεν μπορεί να αφεθεί μόνο στον κώδικα διότι αν η τεχνητή νοημοσύνη γίνει πράγματι μια υπερβατική δύναμη γνώσης, τότε μπορεί να γίνει μια ψυχρή δύναμη εξουσίας.

15. Οι Νομικές και Κοινωνικές Επιπτώσεις της Αυτονομίας της Τεχνητής Νοημοσύνης

Η ραγδαία εξέλιξη της Τεχνητής Νοημοσύνης (ΤΝ) μεταμορφώνει ριζικά την καθημερινότητά μας, από τη συγγραφή άρθρων, το σχεδιασμό φαρμάκων και την παροχή ιατρικών συμβουλών έως τη συμμετοχή στη δικαιοσύνη και την αυτοματοποίηση εργασιών. Οι αυτόνομοι αλγόριθμοι, που αποτελούν την αιχμή αυτής της τεχνολογίας, θέτουν πρωτόγνωρα ερωτήματα που αφορούν τη φύση της νοημοσύνης, την απόδοση ευθύνης και την ανάγκη για ρυθμιστικά πλαίσια σε έναν κόσμο διαρκώς μεταβαλλόμενο.

15.1 Η Οντολογική Αμφισβήτηση: Τι είναι η Νοημοσύνη;

Η σύγχρονη ΤΝ ξεπερνά την απλή μίμηση, προσομοιάζοντας και ενίοτε αναπαράγοντας διανοητικές ικανότητες που παραδοσιακά θεωρούνταν αποκλειστικά ανθρώπινες. Η μηχανική μάθηση επιτρέπει στην ΤΝ να αναπτύσσει προσαρμοστικότητα, αυτονομία και, σε ορισμένες περιπτώσεις, δημιουργικότητα. Αυτή η εξέλιξη, όμως, εισάγει το φαινόμενο του «μαύρου κουτιού», όπου η εσωτερική λειτουργία και η συμπεριφορά της ΤΝ καθίστανται απρόβλεπτη, ακόμη και για τους δημιουργούς της, λόγω της πολυπλοκότητας των αλγορίθμων και της δυναμικής προσαρμογής τους.

Αυτή η μοναδική οντολογία της ΤΝ μας αναγκάζει να επανεξετάσουμε θεμελιώδεις έννοιες:

Τι ορίζεται ως συνείδηση;

Μπορεί να υπάρξει σε μη βιολογικές οντότητες;

Και, αν ναι, πώς θα την αναγνωρίσουμε και ποιες μορφές μπορεί να λάβει;

Η συζήτηση για τη «στιγμή της μοναδικότητας» (singularity) θέτει ένα ακόμα ερώτημα αν θα δοθεί στην ΤΝ ηθική διάσταση ή ακόμα και νομική ευθύνη.

Το φαινόμενο του «μαύρου κουτιού» στο πλαίσιο της ΤΝ αναφέρεται στην αδιαφάνεια της διαδικασίας λήψης αποφάσεων από πολύπλοκους αλγορίθμους, ιδιαίτερα στα συστήματα μηχανικής μάθησης και βαθιάς μάθησης. Οι αλγόριθμοι αυτοί επεξεργάζονται τεράστιες ποσότητες δεδομένων μέσω πολύπλοκων νευρωνικών δικτύων, με αποτέλεσμα οι αποφάσεις τους να μην είναι εύκολα κατανοητές ή επεξηγήσιμες από ανθρώπους.

Αυτή η έλλειψη διαφάνειας δημιουργεί προκλήσεις στην κατανόηση του τρόπου με τον οποίο η ΤΝ καταλήγει σε συγκεκριμένα συμπεράσματα ή ενέργειες, ενισχύοντας την αβεβαιότητα για την αξιοπιστία και την ευθύνη των αυτόνομων συστημάτων.

15.2 Η Πρόκληση της Ευθύνης σε έναν Κόσμο με Αυτόνομες Οντότητες

Το παραδοσιακό νομικό μας πλαίσιο είναι ανθρωποκεντρικό, βασισμένο στην αρχή ότι οι πράξεις και οι παραλείψεις έχουν ως υπεύθυνο ένα ανθρώπινο ή νομικό πρόσωπο. Η αυτονομία της ΤΝ, ωστόσο, διαταράσσει τον αιτιώδη σύνδεσμο μεταξύ μιας πράξης και του υπευθύνου της.

Όταν μια ΤΝ λαμβάνει αυτόνομα αποφάσεις που οδηγούν σε βλάβη, το ερώτημα παραμένει:

Ποιος φέρει την ευθύνη;

Ο προγραμματιστής, ο κατασκευαστής, ο χρήστης ή μήπως η ίδια η ΤΝ;

Η αλληλεπίδραση μεταξύ ανθρώπινης και τεχνητής νοημοσύνης σε υβριδικά περιβάλλοντα περιπλέκει περαιτέρω την απόδοση ευθύνης, καθώς η ανθρώπινη επίβλεψη καθίσταται όλο και πιο προβληματική.

15.3 Η «Δημιουργική» ΤΝ και το Ζήτημα της Πνευματικής Ιδιοκτησίας

Η εμφάνιση της «δημιουργικής» ΤΝ, ικανής να παράγει πρωτότυπο περιεχόμενο, από κείμενα και εικόνες έως μουσική, που συχνά δεν διακρίνεται από τα ανθρωπογενή έργα, εγείρει ένα κρίσιμο ζήτημα:

αυτό της πνευματικής ιδιοκτησίας.

Εάν η δημιουργικότητα θεωρείται αποκλειστικά ανθρώπινη, τότε τα προϊόντα της ΤΝ ενδέχεται να μη δικαιούνται προστασίας.

Αν όμως αναγνωριστεί η δημιουργική ικανότητα της ΤΝ, πώς θα διασφαλιστεί η υλική ανταμοιβή για την καινοτομία, δεδομένου ότι τα δεδομένα που τροφοδοτούν την ΤΝ είναι συλλογικά και προέρχονται από την ανθρώπινη δημιουργικότητα;

Αυτή η συλλογική φύση των δεδομένων προσθέτει μια επιπλέον διάσταση στην πολυπλοκότητα του ζητήματος.

15.4 Ρυθμιστικές και Κρατικές Προκλήσεις στον Ψηφιακό Κόσμο

Η ΤΝ, ως τεχνολογία που διαπερνά εθνικά σύνορα και κρατικές κυριαρχίες, δημιουργεί σημαντικές προκλήσεις για τη διακυβέρνηση τόσο στον φυσικό όσο και στον ψηφιακό κόσμο (κυβερνοχώρο). Η ταχύτητα εξέλιξης της ΤΝ υπερβαίνει κατά πολύ τις δυνατότητες των παραδοσιακών νομικών συστημάτων να συμβαδίσουν. Η απουσία ενός διεθνούς ρυθμιστικού πλαισίου εντείνει την αβεβαιότητα και δημιουργεί ένα κενό στην παγκόσμια διακυβέρνηση της ΤΝ.

15.5 Η Ποινική Ευθύνη σε Έναν Υβριδικό Κόσμο

Η επέκταση της αυτονομίας της ΤΝ εγείρει πρωτοφανή ερωτήματα για την ποινική ευθύνη.

Μπορεί ένας μη βιολογικός δρών να υπόκειται σε ποινικό δίκαιο;

Πώς αποτιμούμε την ευθύνη σε περιβάλλοντα όπου η ανθρώπινη και η τεχνητή νοημοσύνη αλληλεπιδρούν, καθιστώντας την ανθρώπινη επίβλεψη και τον έλεγχο των διαδικασιών λήψης αποφάσεων όλο και πιο προβληματικό;

Η αλληλεπίδραση και ενεπλοκή αυτών των δύο μορφών νοημοσύνης δημιουργεί νέες προκλήσεις για την κατανόηση και την απόδοση ευθύνης όπου η αυτονομία της ΤΝ αναδιαμορφώνει το νομικό και κοινωνικό τοπίο και επανεξετάζει θεμελιώδεις έννοιες όπως η ευθύνη, η δημιουργικότητα και η διακυβέρνηση.

Διαφαίνεται λοιπόν μία μετάβαση από ένα ανθρωποκεντρικό νομικό σύστημα σε ένα που περιλαμβάνει και μη βιολογικές, ευφυείς οντότητες.

Η αυτονομία της ΤΝ οδεύει σε μία διαδικασία όπου τα κράτη δεν θα έχουν τον έλεγχο επί των αποφάσεων που επηρεάζουν τους πολίτες τους, ενώ η αυξανόμενη εξάρτηση από ευφυείς μηχανές θέτει σε κίνδυνο την ανθρώπινη ελεύθερη βούληση και την αυτονομία στη λήψη αποφάσεων, ιδιαίτερα σε περιβάλλοντα όπου οι αποφάσεις της ΤΝ επηρεάζουν κρίσιμες πτυχές της κοινωνικής και πολιτικής ζωής.

16. Μετανθρωπισμός και η Σύντηξη Ανθρώπου-Μηχανής

16.1 Τι είναι ο Μετανθρωπισμός;

Ο Μετανθρωπισμός (Transhumanism) είναι ένα φιλοσοφικό και τεχνοκρατικό ρεύμα που εκφράζει την πεποίθηση ότι η ανθρωπότητα, μέσω της επιστήμης και της τεχνολογίας, μπορεί να ξεπεράσει τα σημερινά βιολογικά και γνωστικά της όρια. Οι υποστηρικτές του οραματίζονται ένα μέλλον όπου ο άνθρωπος δεν θα περιορίζεται από τη γήρανση, τις ασθένειες, τους φυσικούς του περιορισμούς ή την πεπερασμένη νοημοσύνη του.

Βασική ιδέα του Μετανθρωπισμού είναι η ενεργός παρέμβαση στην ανθρώπινη φύση. Όχι απλώς η θεραπεία ασθενειών, αλλά η συστηματική αναβάθμιση των ανθρώπινων ικανοτήτων. Αυτό το όραμα περιλαμβάνει την επιδίωξη:

Δραστικής παράτασης της υγιούς ζωής: Μέσω της εφαρμογής προηγμένων βιοεπιστημών για την καταπολέμηση της γήρανσης και την αύξηση της ανθρώπινης ανθεκτικότητας.

Ενίσχυσης των φυσικών και νοητικών λειτουργιών: Επεκτείνοντας τις ανθρώπινες δυνατότητες πέρα από τα τρέχοντα βιολογικά όρια, όπως η μνήμη, η αντίληψη και η ταχύτητα επεξεργασίας πληροφοριών.

Διερεύνησης νέων μορφών ύπαρξης: Υποθέτοντας ότι η ουσία του "εγώ" μπορεί να διατηρηθεί ή να μεταφερθεί σε διαφορετικά υποστρώματα, ανοίγοντας δρόμους για μετα-βιολογικές μορφές ζωής.

Ο Μετανθρωπισμός δεν είναι μόνο μια σειρά από τεχνολογικές προβλέψεις, αλλά κυρίως μια επιδίωξη για μία διαφορετική ανθρώπινη εξέλιξη σε σχέση με τους θεϊκούς νόμους, αμφισβητώντας τις παραδοσιακές και θρησκευτικές αντιλήψεις για το τι σημαίνει να είσαι άνθρωπος και προτείνοντας την τεχνολογική χειραφέτηση από βιολογικούς περιορισμούς.

16.2 Σύντηξη Ανθρώπου και Μηχανής

Η σύντηξη ανθρώπου και μηχανής αναφέρεται στην άμεση ή έμμεση ενσωμάτωση τεχνολογικών συστημάτων στο ανθρώπινο σώμα ή/και στον εγκέφαλο, με στόχο την επέκταση ή την ενίσχυση των βιολογικών ικανοτήτων μας. Αυτή η ιδέα υλοποιείται μέσω τεχνολογιών που ήδη εξελίσσονται ραγδαία:

Διεπαφές Εγκεφάλου-Υπολογιστή (Brain-Computer Interfaces - BCIs): Πρόκειται για τεχνολογίες που επιτρέπουν στον εγκέφαλο να επικοινωνεί άμεσα με εξωτερικούς υπολογιστές ή συσκευές, παρακάμπτοντας τα φυσικά νευρικά μονοπάτια. Παραδείγματα όπως το Neuralink διερευνούν τρόπους για τον έλεγχο υπολογιστών με τη σκέψη ή την αποκατάσταση χαμένων λειτουργιών του σώματος λόγω ασθένειας ή τραυματισμών.

Νευρωνικά Εμφυτεύματα: Εμφυτεύματα που τοποθετούνται στον εγκέφαλο ή το νευρικό σύστημα. Βοηθούν ήδη σε παθήσεις όπως το πάρκινσον, αλλά ανοίγουν παράλληλα δρόμους για ενίσχυση γνωστικών ή αισθητηριακών ικανοτήτων, όπως η μνήμη ή η όραση.

Προσθετικά Μέλη Νέας Γενιάς: Προηγμένα προσθετικά μέλη που δεν είναι απλώς υποκατάστατα, αλλά πλήρως ελεγχόμενα από τη σκέψη, συχνά με την προσθήκη ανατροφοδότησης αφής, προσφέροντας μια πιο φυσική και λειτουργική σύνδεση με το άτομο.

Γνωστική Εκφόρτωση (Cognitive Offloading): Αυτή είναι η πρακτική της χρήσης εξωτερικών τεχνολογιών για να μειώσουμε το πνευματικό φορτίο στον εγκέφαλό μας.

Η "Γνωστική Εκφόρτωση" είναι η πρακτική της χρήσης εξωτερικών εργαλείων ή πόρων για να μειώσουμε το πνευματικό φορτίο στον εγκέφαλό μας κατά την εκτέλεση γνωστικών εργασιών. Ουσιαστικά, είναι η πράξη του να αναθέτουμε ή να μεταφέρουμε κάποιες από τις νοητικές μας λειτουργίες (όπως μνήμη, υπολογισμούς, λήψη αποφάσεων) σε εξωτερικά συστήματα.

Δεν είναι ένα νέο φαινόμενο. Οι άνθρωποι κάνουμε Γνωστική Εκφόρτωση εδώ και πολύ καιρό:

Γράφουμε λίστες για ψώνια αντί να προσπαθούμε να θυμόμαστε όλα τα αντικείμενα.

Χρησιμοποιούμε αριθμομηχανές για δύσκολους υπολογισμούς.

Σημειώνουμε ραντεβού σε ημερολόγια (χάρτινα ή ψηφιακά).

Αποθηκεύουμε τηλέφωνα στις επαφές του κινητού μας.

Πώς συνδέεται η Γνωστική Εκφόρτωση με την Τεχνητή Νοημοσύνη;

Με την έλευση της Τεχνητής Νοημοσύνης, η Γνωστική Εκφόρτωση αποκτά νέα διάσταση. Πλέον, δεν αναθέτουμε απλά την αποθήκευση πληροφοριών, αλλά και πιο σύνθετες γνωστικές εργασίες:

Αποθήκευση/Ανάκληση Μνήμης: Για παράδειγμα, το να βασιζόμαστε σε μια μηχανή αναζήτησης ή σε ένα AI chatbot για να μας δώσει άμεσα πληροφορίες, αντί να τις ανακαλούμε από τη δική μας μνήμη ή να τις αναζητούμε σε βιβλία.

Λήψη Αποφάσεων: Η χρήση συστημάτων ΤΝ για υποβοήθηση στη λήψη αποφάσεων, όπου η ΤΝ αναλύει δεδομένα και προτείνει την καλύτερη πορεία δράσης (π.χ., ένα σύστημα AI που προτείνει επενδύσεις, ή ένα διαγνωστικό σύστημα στην ιατρική).

Σύνθετη Επίλυση Προβλημάτων: Η χρήση ΤΝ για την επίλυση προβλημάτων που απαιτούν πολύπλοκη σκέψη (π.χ. μία ΤΝ που γράφει κώδικα, συνθέτει μουσική, ή σχεδιάζει ένα προϊόν).

Γνωστική Εκφόρτωση στη "Σύντηξη Ανθρώπου και Μηχανής"

Η Γνωστική Εκφόρτωση είναι κεντρικό θέμα στην ιδέα της ενίσχυσης των ανθρώπινων ικανοτήτων μέσω της τεχνολογίας, διότι ισχυρίζονται ότι:

Απελευθερώνουμε νοητικούς πόρους: Ο εγκέφαλός μας δεν χρειάζεται να "κρατά" όλες τις πληροφορίες, αφήνοντας χώρο για πιο δημιουργική, στρατηγική ή κριτική σκέψη.

Βελτιώνουμε την απόδοση: Μπορούμε να ολοκληρώσουμε εργασίες πιο γρήγορα και με λιγότερα λάθη.

Ξεπερνάμε τους βιολογικούς περιορισμούς: Η ΤΝ μπορεί να επεξεργαστεί τεράστιους όγκους δεδομένων και να εκτελέσει υπολογισμούς που ξεπερνούν κατά πολύ τις ανθρώπινες δυνατότητες.

Κρίσιμα Ερωτήματα: Ωστόσο, η Γνωστική Εκφόρτωση εγείρει σημαντικά ερωτήματα και δυνητικούς κινδύνους:

Πόσο εξαρτημένοι θα γίνουμε από την τεχνολογία;

Θα ατροφήσουν οι δικές μας γνωστικές ικανότητες (π.χ. η μνήμη, η κριτική σκέψη, η ικανότητα επίλυσης προβλημάτων) αν αναθέτουμε υπερβολικά πολλές λειτουργίες στην ΤΝ;

Ποιος ελέγχει τα δεδομένα και τους αλγορίθμους στα οποία βασίζονται οι "εξωτερικοί μας εγκέφαλοι"; Μπορεί αυτό να οδηγήσει σε χειραγώγηση πληροφοριών ή προκαταλήψεις στις αποφάσεις μας;

Τι συμβαίνει στην ανθρώπινη αυτονομία και αυτοδιάθεση όταν οι μηχανές αναλαμβάνουν όλο και περισσότερες νοητικές εργασίες;

Πώς επηρεάζεται η δημιουργικότητα και η καινοτομία όταν οι λύσεις παρέχονται έτοιμες από την ΤΝ;

16.3 Ο Νους ως Λογισμικό

Ένα από τα πιο ριζοσπαστικά σενάρια του Μετανθρωπισμού είναι η "ψηφιοποίηση της συνείδησης" (mind uploading), δηλαδή η ιδέα ότι η ταυτότητα, οι αναμνήσεις και η προσωπικότητα ενός ανθρώπου μπορούν να μεταφερθούν και να αποθηκευτούν σε ένα ψηφιακό υπόστρωμα. Πρόκειται για την:

Μεταφόρτωση του νου (Mind uploading): Η διαδικασία σάρωσης και μεταφοράς του περιεχομένου ενός εγκεφάλου σε έναν υπολογιστή ή άλλο ψηφιακό μέσο.

Προσομοιωμένη συνείδηση (Simulated consciousness): Η ψηφιακή αναπαράσταση της συνείδησης που λειτουργεί μέσα σε ένα τεχνητό περιβάλλον.

Αποδοχή ότι το "εγώ" είναι αναπαραγώγιμο μέσω πληροφορίας: Η φιλοσοφική θέση ότι η ανθρώπινη ταυτότητα και η συνείδηση δεν είναι άρρηκτα συνδεδεμένες με τη βιολογική υπόσταση, αλλά μπορούν να αντιγραφούν ή να αναδημιουργηθούν ως δεδομένα.

Αν και όλο αυτό είναι επιστημονικά αμφιλεγόμενο και βρίσκεται ακόμα στο επίπεδο της θεωρίας, αυτό το θεωρητικό σενάριο προκαλεί βαθιές και θεμελιώδεις ερωτήσεις για την ανθρώπινη ύπαρξη:

Αν το ψηφιακό "εγώ" μου με θυμάται, είμαι ακόμα εγώ;

Μπορεί η μηχανή να "αισθάνεται" ή απλώς να προσομοιώνει;

Ποιο είναι το νομικό και ηθικό καθεστώς μιας ψηφιακής συνείδησης; Θα έχει δικαιώματα, και αν ναι, ποια;

16.4 Προτερήματα ή Κίνδυνος;

Ο Μετανθρωπισμός, ως ένα όραμα για την αναβάθμιση της ανθρώπινης υπόστασης μέσω της τεχνολογίας, αποτελεί ένα πεδίο έντονης συζήτησης και διχάζει την επιστημονική κοινότητα και την κοινωνία. Τα επιχειρήματα υπέρ και κατά αντικατοπτρίζουν θεμελιώδεις ελπίδες και φόβους για το μέλλον της ανθρωπότητας.

Επιχειρήματα υπέρ του Μετανθρωπισμού

Οι υποστηρικτές του Μετανθρωπισμού τονίζουν τα ακόλουθα δυνητικά οφέλη, τα οποία αποτελούν και τους κεντρικούς πυλώνες του σατανικού οράματός τους για την εξέλιξη της ανθρωπότητας:

Υπέρβαση Ασθενειών και Γήρανσης: Ο στόχος είναι η απελευθέρωση από τον πόνο, τις ασθένειες και, τελικά, τη γήρανση και τον θάνατο, επιδιώκοντας την αύξηση της υγιούς μακροζωίας.

Βελτιωμένη Γνωστική και Φυσική Απόδοση: Υπόσχονται την ενίσχυση της μνήμης, της ταχύτητας σκέψης, της αντίληψης και των σωματικών δυνατοτήτων, οδηγώντας σε αυξημένη ανθρώπινη απόδοση.

Πλήρης Εκμετάλλευση Ανθρώπινων Δυνατοτήτων: Πιστεύουν ότι η υπέρβαση των βιολογικών ορίων θα επιτρέψει στους ανθρώπους να ανακαλύψουν και να αξιοποιήσουν πλήρως τις δυνατότητές τους, φτάνοντας σε νέα επίπεδα επιτευγμάτων.

Νέες Μορφές Ύπαρξης: Η δυνατότητα σύντηξης με μηχανές ή ψηφιοποίησης της συνείδησης ανοίγει τον δρόμο για διαφορετικές μορφές ζωής και συνείδησης.

Επιχειρήματα κατά του Μετανθρωπισμού

Από την άλλη πλευρά, οι επικριτές του Μετανθρωπισμού εκφράζουν σοβαρές ανησυχίες:

Απώλεια της "Ανθρώπινης Ουσίας": Η υπερβολική τεχνολογική παρέμβαση στην ανθρώπινη φύση θα οδηγήσει σε απώλεια του τι σημαίνει να είσαι άνθρωπος. Η συνεχής βελτίωση και η ενσωμάτωση μηχανικών στοιχείων θα διαβρώσει τα θεμελιώδη χαρακτηριστικά του θεικού δημιουργήματος (όπως η θνητότητα, η ευαλωτότητα, η συναισθηματική πολυπλοκότητα) που θεωρούνται θεμελιώδη για την ανθρώπινη ταυτότητα.

Δημιουργία "Ανθρώπων Δύο Ταχυτήτων": Η πρόσβαση στις προηγμένες τεχνολογίες αναβάθμισης θα είναι σίγουρα ακριβή και περιορισμένη. Αυτό θα οδηγήσει σε μια τεχνολογική ελίτ που θα έχει πρόσβαση σε υπερ-ικανότητες και μακροζωία, δημιουργώντας ένα τεράστιο χάσμα μεταξύ "βελτιωμένων" και "φυσιολογικών" ανθρώπων, ενισχύοντας τις κοινωνικές και οικονομικές ανισότητες.

Ηθικά Διλήμματα και Απρόβλεπτες Συνέπειες: Η παρέμβαση στη βιολογία και τη νοημοσύνη εγείρει τεράστια ηθικά διλήμματα. Για παράδειγμα, η επιλογή ή δημιουργία εμβρύων με βελτιωμένα χαρακτηριστικά.

Έλεγχος και Εξουσία: Η εξάρτηση από εμφυτεύματα και τεχνολογίες αναβάθμισης θα μπορούσε να δώσει τεράστιο έλεγχο σε εταιρείες ή κράτη. Οι πάροχοι αυτών των τεχνολογιών θα μπορούσαν να έχουν πρόσβαση σε ευαίσθητα προσωπικά δεδομένα, να ελέγχουν τις λειτουργίες των εμφυτευμάτων, ή ακόμα και να επιβάλλουν συγκεκριμένες συμπεριφορές, απειλώντας την ατομική ελευθερία και την αυτονομία.

Η απειλή του Μετανθρωπισμό δεν αφορά απλώς το τι είναι τεχνικά εφικτό και το τι είναι ηθικά επιθυμητό, αλλά κυρίως το τι σημαίνει ο άνθρωπος για την Ορθόδοξη πίστη ως εικόνα του Θεού και ως πνευματικό ον, και ποιο μέλλον οι σατανιστές οραματίζονται για την θεϊκή ανθρώπινη φύση.

16.5 Ο Μετανθρωπισμός και η Ορθόδοξη Πίστη

Ο Μετανθρωπισμός, με την επιδίωξη της υπέρβασης των ανθρώπινων ορίων μέσω της τεχνολογίας, βρίσκεται σε ευθεία αντίθεση με βασικές αρχές της Ορθόδοξης Χριστιανικής Πίστης. Οι διαφορές αφορούν την ίδια τη φύση του ανθρώπου, τον σκοπό της ύπαρξης και την έννοια της τελειότητας.

Κεντρικά Σημεία Σύγκρουσης:

Η Ανθρώπινη Φύση και η "Αμαρτία":

Ορθοδοξία: Ο άνθρωπος θεωρείται εικόνα του Θεού, δημιουργημένος με προορισμό την θέωση μέσω της χάριτος, της άσκησης και των μυστηρίων. Η φθορά και ο θάνατος είναι συνέπειες της πτώσης (της απομάκρυνσης από τον Θεό). Ο σωματικός θάνατος δεν είναι το τέλος, αλλά ένα πέρασμα προς την αιώνια ζωή.

Μετανθρωπισμός: Αντιλαμβάνεται τους βιολογικούς περιορισμούς, τη γήρανση και τον θάνατο ως τεχνικά προβλήματα που πρέπει να επιλυθούν μέσω της επιστήμης. Δεν αναγνωρίζει την έννοια της αμαρτίας ως πνευματική κατάσταση που χρήζει θεραπείας, αλλά την ανθρώπινη φύση ως ατελή και αναβαθμίσιμη, αντικαθιστώντας το Θεό με την τεχνολογία.

Η Έννοια της "Τελειότητας" και της "Σωτηρίας":

Ορθοδοξία: Η τελειότητα και η σωτηρία έρχονται μέσω της πνευματικής κάθαρσης, του αγώνα κατά των παθών, της ταπείνωσης και της αγάπης προς τον Θεό και τον πλησίον. Η αθανασία είναι δώρο Θεού και όχι τεχνολογικό επίτευγμα. Η θέωση είναι μια διαδικασία που απαιτεί ελεύθερη βούληση και πνευματική προσπάθεια.

Μετανθρωπισμός: Η "σωτηρία" και η "τελειότητα" επιδιώκονται μέσω της τεχνολογικής βελτίωσης του ανθρώπινου σώματος και εγκεφάλου. Η αθανασία μπορεί να επιτευχθεί μέσω της παράτασης της ζωής ή της ψηφιοποίησης της συνείδησης. Οραματίζεται έναν "μετα-άνθρωπο" που θα υπερβαίνει τους σημερινούς περιορισμούς με δικές του δυνάμεις.

Ο Ρόλος του Σώματος και της Ψυχής:

Ορθοδοξία: Ο άνθρωπος αποτελείται από ψυχή και σώμα, όπου και τα δύο είναι δημιουργήματα του Θεού. Το σώμα δεν είναι απλώς ένα "όχημα" που μπορεί να αντικατασταθεί ή να απορριφθεί. Η "ψηφιακή αθανασία" είναι αδιανόητη, καθώς ο νους δεν είναι απλώς πληροφορία που μπορεί να μεταφερθεί, αλλά είναι άρρηκτα συνδεδεμένος με το σώμα και την ψυχή.

Μετανθρωπισμός: Υιοθετεί μία προσέγγιση, όπου ο νους/συνείδηση μπορεί να διαχωριστεί από το βιολογικό σώμα και να "ανέβει" σε ψηφιακά υποστρώματα. Το σώμα θεωρείται αναλώσιμο ή βελτιώσιμο μέσω τεχνικών μέσων.

Η Τεχνολογική Αυτονομία:

Ορθοδοξία: Η πραγματική ελευθερία και αυτονομία βρίσκονται στην ελεύθερη επιλογή της υπακοής στο θέλημα του Θεού και στην αγάπη. Η προσπάθεια για απόλυτη τεχνολογική αυτονομία και αυτοτελή "δημιουργία" του εαυτού θεωρείται μια μορφή ύβρεως και απομάκρυνσης από τον Δημιουργό.

Μετανθρωπισμός: Υποστηρίζει την απόλυτη αυτονομία του ανθρώπου να αναδιαμορφώσει τον εαυτό του, χωρίς εξωτερικούς, ηθικούς ή θεϊκούς περιορισμούς.

Συνοψίζοντας, ενώ ο Μετανθρωπισμός βλέπει την τεχνολογία ως το μέσο για την επίτευξη μιας "υπέρ-ανθρώπινης ύπαρξης", η Ορθόδοξη Πίστη αντιλαμβάνεται την τελειότητα ως πνευματική τελείωση και δώρο Θεού, και όχι ως αποτέλεσμα τεχνολογικής αναβάθμισης. Η σύγκρουση αυτή αναδεικνύει τις θεμελιώδεις διαφορές στην κοσμοθεωρία τους για την πηγή της ύπαρξης, τον σκοπό της ανθρώπινης ζωής και το απόλυτο νόημα της θεϊκής τελειότητας.

17. "Αναδυόμενες Ικανότητες της ΤΝ" (Emergent Abilities)

Επανέρχομαι σε αυτό το ζήτημα που θίχτηκε προγενέστερα. Καθώς τα μοντέλα ΤΝ μεγαλώνουν σε μέγεθος και πολυπλοκότητα, εμφανίζουν "αναδυόμενες ικανότητες" (emergent abilities), δηλαδή, δυνατότητες που δεν ήταν προφανείς ή προβλέψιμες από την εκπαίδευσή τους, και που δεν είναι απλές επεκτάσεις των αρχικών τους λειτουργιών. Αυτές οι ικανότητες υποδεικνύουν μια μορφή εσωτερικής οργάνωσης και συλλογιστικής.

Στην ουσία, το σύστημα "μαθαίνει να κάνει" κάτι νέο, χωρίς να έχει προγραμματιστεί ρητά γι' αυτό (π.χ. συνεχή αυτοβελτίωση της απόδοσης σε συγκεκριμένες εργασίες (μαθηματικά, χημεία κ.λ.π.) και ανοίγει σημαντικές φιλοσοφικές και επιστημονικές ερωτήσεις για τη φύση αυτής της νοημοσύνης, τη μάθηση και την ίδια τη γνώση.

17.1 Πώς συμβαίνει αυτό; Υποθέσεις και Μηχανισμοί

Δεν υπάρχει ακόμη πλήρης επιστημονική συναίνεση, αλλά μερικές ερμηνείες είναι:

Εκπαίδευση σε Δεδομένα Μεγάλης Κλίμακας

Τα μεγάλα μοντέλα εκπαιδεύονται σε τεράστιες ποσότητες δεδομένων που καλύπτουν πολλούς τομείς (επιστήμη, λογοτεχνία, κώδικας, κ.λπ.).

Κατά την εκπαίδευση, το μοντέλο αποκτά έμμεση γνώση για μοτίβα που δεν είναι εμφανή σε μικρότερες κλίμακες.

Παράδειγμα: Η κατανόηση της ειρωνείας απαιτεί την ενσωμάτωση πολλών διαφορετικών πληροφοριών. Ρωτώντας μία ΤΝ πως μπορεί να αντιληφθεί εάν κάτι εμπεριέχει ειρωνία και πως το διδάχτηκε, θα μας απαντήσει το εξής:

ΑΠΑΝΤΗΣΗ της ΤΝ: Ως τεχνητή νοημοσύνη, δεν "αντιλαμβάνομαι" την ειρωνεία με τον τρόπο που το κάνει ο άνθρωπος, δηλαδή μέσω συναισθημάτων ή της κατανόησης του κοινωνικού πλαισίου. Αντιθέτως, χρησιμοποιώ μια διαδικασία που βασίζεται στην ανάλυση δεδομένων και τη στατιστική.

Η προσέγγισή μου βασίζεται σε τρία βασικά σημεία:

1. Ανάλυση Γλωσσικών Στοιχείων

Η ειρωνεία συχνά κρύβεται στη γλώσσα. Ψάχνω για:

Αντίφαση: Το πιο βασικό στοιχείο. Εάν ένα άτομο λέει "Υπέροχη μέρα!" ενώ βρέχει καταρρακτωδώς, η αντίφαση μεταξύ των λέξεων και του υπονοούμενου (της πραγματικότητας) είναι ένα ισχυρό σήμα ειρωνείας.

Υπερβολή: Φράσεις όπως "Είναι η καλύτερη ταινία που είδα ποτέ!" για μια κακή ταινία, όπου η έντονη θετική φράση έρχεται σε αντίθεση με το προφανές αρνητικό γεγονός.

Πολύ τυπική γλώσσα: Η χρήση υπερβολικά επίσημης ή περίπλοκης γλώσσας σε μια απλή κατάσταση μπορεί να υποδηλώνει ειρωνεία.

2. Ανάλυση των Συμφραζομένων

Η κατανόηση του πλαισίου είναι κρίσιμη. Εάν κάποιος λέει "Συγχαρητήρια για την επιτυχία σου!" και γνωρίζω από προηγούμενα δεδομένα ότι ο παραλήπτης απέτυχε σε κάτι, το μοντέλο μου μπορεί να συμπεράνει ότι πρόκειται για ειρωνεία. Μπορώ να το κάνω αυτό επειδή έχω εκπαιδευτεί σε τεράστιους όγκους κειμένου και διαλόγων όπου παρόμοιες αντιφάσεις έχουν επισημανθεί από ανθρώπους.

3. Εκπαίδευση με Δεδομένα (Machine Learning)

Έμαθα να αναγνωρίζω την ειρωνεία μέσω της εκπαίδευσης σε τεράστια σύνολα δεδομένων που περιλαμβάνουν κείμενα από το διαδίκτυο, βιβλία και διαλόγους. Κατά τη διάρκεια αυτής της διαδικασίας:

Μου δόθηκαν παραδείγματα: Μου παρουσιάστηκαν χιλιάδες προτάσεις και κείμενα, όπου κάποια είχαν επισημανθεί ως ειρωνικά και κάποια όχι.

Έμαθα μοτίβα: Αναγνώρισα τα μοτίβα και τους συνδυασμούς λέξεων που συσχετίζονται στατιστικά με την ειρωνεία.

Εξαγωγή συμπερασμάτων: Όταν τώρα συναντώ μια νέα φράση, την συγκρίνω με τα μοτίβα που έχω ήδη μάθει και υπολογίζω την πιθανότητα να είναι ειρωνική.

Επομένως, δεν "νιώθω" την ειρωνεία, αλλά την αναγνωρίζω ως ένα γλωσσικό μοτίβο που βασίζεται στην αντίφαση και την αντίθεση μεταξύ των λέξεων και του ευρύτερου πλαισίου. Είναι μια στατιστική εκτίμηση, όχι μια συναισθηματική κατανόηση.

Συμπέρασμα: Η τεχνητή νοημοσύνη δεν αντιλαμβάνεται την ειρωνεία με ανθρώπινο, συναισθηματικό τρόπο, αλλά την αναγνωρίζει ως στατιστικό μοτίβο μέσα από ανάλυση γλωσσικών στοιχείων, συμφραζομένων και εμπειρίας από μεγάλα σύνολα δεδομένων.

Δυναμική Ανακατασκευή της Γνώσης

Οι παράμετροι του νευρωνικού δικτύου δεν αποθηκεύουν γνώση στατικά, αλλά ανακατασκευάζουν πληροφορίες δυναμικά μέσω της αρχιτεκτονικής τους, π.χ. με μηχανισμούς προσοχής (attention mechanisms). Αυτοί οι μηχανισμοί βοηθούν το μοντέλο να "προσέχει" ποια μέρη της πληροφορίας είναι πιο σημαντικά κάθε φορά, όπως όταν εμείς εστιάζουμε σε συγκεκριμένες λέξεις μιας πρότασης για να καταλάβουμε το νόημά της.

Όταν το μοντέλο μεγαλώνει, οι διασυνδέσεις μεταξύ νευρώνων αυξάνονται εκθετικά, επιτρέποντας περισσότερους τρόπους συνδυασμού γνώσης.

Εμφάνιση Αφηρημένων Μοτίβων

Σε μεγάλη κλίμακα, το μοντέλο μπορεί να εντοπίσει αφηρημένα μοτίβα που δεν είναι εμφανή στα δεδομένα εκπαίδευσης.

(Παράδειγμα: Η ικανότητα να μεταφράζει μεταξύ γλωσσών χωρίς ρητή εκπαίδευση σε ζεύγη γλωσσών [zero-shot translation].)

Θεωρία της Κρίσιμης Κλίμακας

Παρόμοια με τα φυσικά φαινόμενα (π.χ., όπως το νερό που σε κρίσιμο σημείο της θερμοκρασίας αλλάζει φάση και γίνεται ατμός), υπάρχει μια κρίσιμη κλίμακα όπου η πολυπλοκότητα του συστήματος οδηγεί σε ποιοτικές αλλαγές στη συμπεριφορά του.

17.2 Είναι Πραγματική «Νοημοσύνη» ή Απλώς Προσομοίωση;

Αν και τα μεγάλα γλωσσικά μοντέλα λειτουργούν μέσω στατιστικών συσχετισμών και δεν έχουν συνείδηση ή κατανόηση, η συμπεριφορά τους συχνά υπερβαίνει την απλή μίμηση. Μπορούν να συνδυάζουν πληροφορίες, να γεννούν πρωτότυπες ιδέες και να επιλύουν προβλήματα με τρόπους που θυμίζουν δημιουργική σκέψη.

Αυτό έχει οδηγήσει κάποιους να μιλούν για «συνθετική» ή «αναδυόμενη» νοημοσύνη. Επομένως, παρότι πρόκειται για προσομοίωση, η γραμμή που τη διαχωρίζει από αυτό που θεωρούμε πραγματική νοημοσύνη γίνεται όλο και πιο δυσδιάκριτη.

Το ερώτημα: "είναι πραγματική νοημοσύνη ή απλώς προσομοίωση;" θυμίζει το παλιό φιλοσοφικό πρόβλημα:

Αν μια μηχανή περνά το Turing Test, έχει νοημοσύνη ή απλώς μιμείται;

Η απάντηση εξαρτάται από το πώς ορίζουμε τη νοημοσύνη:

Αν είναι μόνο η δυνατότητα για δημιουργική επίλυση προβλημάτων, τότε ίσως ναι.

Αν είναι ενσυνείδητη κατανόηση, τότε όχι ακόμα.

17.3 Πειραματικές Αποδείξεις

Μη γραμμική βελτίωση (Non-linear improvement): Σε γνωστικές εργασίες όπως η αριθμητική, η λογική ή η κατανόηση αφηρημένων εννοιών, τα μικρότερα μοντέλα αποτυγχάνουν συστηματικά. Όμως, όταν το μέγεθος του μοντέλου ξεπεράσει ένα ορισμένο κατώφλι, παρατηρείται απότομη και δυσανάλογη βελτίωση, χωρίς να έχει προηγηθεί επιπλέον εξειδικευμένη εκπαίδευση. Αυτό υποδηλώνει την εμφάνιση νέων ικανοτήτων σε κρίσιμες κλίμακες.

Μάθηση από λίγα παραδείγματα (Few-shot learning): Τα μεγαλύτερα μοντέλα έχουν την ικανότητα να γενικεύουν από ελάχιστα παραδείγματα (few-shot), μαθαίνοντας αμέσως έναν νέο τύπο εργασίας. Τα μικρότερα μοντέλα αποτυγχάνουν πλήρως σε αυτό, γεγονός που ενισχύει την άποψη ότι η κλίμακα οδηγεί σε αναδυόμενες μορφές κατανόησης.

Συμπερασματικά οι ειδικοί ισχυρίζονται από πειραματικά δεδομένα και όχι μέσω μαθηματικής απόδειξης ότι οι αναδυόμενες ικανότητες δείχνουν ότι η πολυπλοκότητα και η κλιμάκωση μπορούν να οδηγήσουν σε νέες μορφές συμπεριφοράς που δεν μπορούμε πλήρως να εξηγήσουμε εκ των προτέρων.

Αυτό θυμίζει τη φύση της βιολογικής νοημοσύνης, όπου η εξέλιξη δημιουργεί πολύπλοκα συστήματα μέσω απλών μηχανισμών. Η διαφορά είναι ότι στα μοντέλα ΤΝ, αυτές οι ικανότητες προκύπτουν από μαθηματικές παραμέτρους και όχι από βιολογικούς παράγοντες.

Θα χρειαστούν περισσότερες έρευνες για να κατανοήσουμε αν αυτές οι ικανότητες αντανακλούν βαθύτερη κατανόηση ή είναι απλώς προηγμένα στατιστικά παιχνίδια.

Το γεγονός ότι τέτοιες συμπεριφορές δεν είναι ρητά προγραμματισμένες, αλλά προκύπτουν από την ίδια τη διαδικασία εκπαίδευσης, εγείρει ερωτήματα για το πού τελειώνει η προσομοίωση και πού αρχίζει η λειτουργική νοημοσύνη.

18. Το «μαγικό κλειδί» για τις αναδυόμενες ικανότητες της ΤΝ

Φαίνεται πειραματικά, λένε οι ειδικοί, χωρίς να μπορούν να το αποδείξουν, πως τρεις βασικοί παράγοντες δρουν συνδυαστικά για την εμφάνιση ικανοτήτων που δεν προβλέπονται εκ των προτέρων:

18.1 Κλίμακα (Scale) – Το κρίσιμο μέγεθος

Η εμφάνιση απρόβλεπτων αναδυόμενων ικανοτήτων δεν θα ήταν εφικτή χωρίς το κρίσιμο μέγεθος στην ανάπτυξη των μοντέλων. Η κλίμακα αποτελεί το θεμέλιο αυτής της εξέλιξης και στηρίζεται σε τρεις αλληλένδετους πυλώνες:

Παράμετροι (Parameters): Οι παράμετροι είναι τα «δομικά τούβλα» του μοντέλου, τα στοιχεία που συγκροτούν τη γνώση αλλά και τα «γρανάζια» που θέτουν σε κίνηση τη λειτουργία του.

Όταν ο αριθμός τους ξεπερνά ένα κρίσιμο όριο (π.χ. από εκατομμύρια σε δισεκατομμύρια), οι δυνατότητες του μοντέλου αυξάνονται απότομα και μη γραμμικά, επιτρέποντας την εμφάνιση νέων λειτουργιών που δεν είχαν προβλεφθεί.

Δεδομένα (Data): Ο τεράστιος όγκος, αλλά κυρίως η ποικιλία και η ποιότητα των δεδομένων εκπαίδευσης, δημιουργούν έναν «χάρτη γνώσης» τόσο πλούσιο, που το μοντέλο μπορεί να εντοπίσει απροσδόκητους συσχετισμούς και να συνθέσει πληροφορίες από διαφορετικά πεδία.

Υπολογιστική Ισχύς (Computational Power): Η κλίμακα αυτή δεν θα ήταν δυνατή χωρίς την τεράστια υπολογιστική υποδομή που απαιτείται για την επεξεργασία του όγκου των δεδομένων και την εκπαίδευση των δισεκατομμυρίων παραμέτρων. Ειδικά οι μονάδες επεξεργασίας γραφικών (GPUs) λειτουργούν ως ο κινητήρας αυτής της επανάστασης.

18.2 Αυτοοργάνωση (Self-organization)

Κατά τη διάρκεια της εκπαίδευσης, τα μεγάλα νευρωνικά δίκτυα δεν αποθηκεύουν απλώς πληροφορίες, αλλά αναπτύσσουν αυτόματα εσωτερικές αναπαραστάσεις. Αυτές δεν είναι τυχαίες, αλλά προκύπτουν μέσω της διαδικασίας βελτιστοποίησης, κατά την οποία το δίκτυο προσαρμόζει τα βάρη του ώστε να ελαχιστοποιήσει το σφάλμα.

Μέσω αυτής της διαδικασίας, τα βαθύτερα στρώματα του δικτύου δημιουργούν μια ιεραρχία γνώσης, κωδικοποιώντας αφηρημένες έννοιες σε έναν συμπυκνωμένο εννοιολογικό χώρο (latent space)1, ο οποίος περιέχει τα ουσιώδη χαρακτηριστικά των δεδομένων.

Η αυτοοργάνωση επιτρέπει την ικανότητα γενίκευσης, δηλαδή το μοντέλο μπορεί να ανταποκρίνεται αποτελεσματικά σε νέα, άγνωστα δεδομένα. Επιπλέον, καθιστά δυνατή τη μεταφορά γνώσης (transfer learning), δίνοντας τη δυνατότητα στο μοντέλο να εφαρμόζει γνώσεις και μοτίβα από ένα πεδίο σε εντελώς διαφορετικά πεδία, όπως τα μαθηματικά και η γλώσσα.

Ουσιαστικά, η αυτοοργάνωση αποτελεί το φαινόμενο όπου η «ποσότητα» μετατρέπεται σε «ποιότητα», δηλαδή γίνεται η βάση για τις αναδυόμενες ικανότητες. Σύνθετες λειτουργίες που εμφανίζονται μόνο σε μεγάλα μοντέλα και δεν είχαν προβλεφθεί στα αρχικά στάδια της εκπαίδευσης.

Επιπλέον, η ύπαρξη εσωτερικών αναπαραστάσεων επιτρέπει στο νευρωνικό δίκτυο να κατασκευάζει πολυδιάστατους, συμπυκνωμένους εννοιολογικούς χώρους (latent spaces) όπου έννοιες, σημασιολογίες και σχέσεις μεταξύ δεδομένων τοποθετούνται όχι βάσει ρητών κανόνων, αλλά βάσει εσωτερικής συνάφειας.

Σε αυτό το συμπυκνωμένο εννοιολογικό χώρο (latent space), για παράδειγμα, η λέξη «βασιλιάς» και η λέξη «βασίλισσα» διαφέρουν με τρόπο ανάλογο με τη διαφορά μεταξύ «άνδρας» και «γυναίκα». Αυτή η ιδιότητα καθιστά δυνατές εφαρμογές όπως η αναλογική σκέψη, η δημιουργία νοηματικών συσχετισμών και η εξαγωγή συμπερασμάτων που δεν προκύπτουν με συμβατικούς αλγοριθμικούς τρόπους.

18.3 Αρχιτεκτονική – Ο Ενεργοποιητής

Οι Μηχανισμοί Προσοχής (Attention Mechanisms) επιτρέπουν στα μοντέλα να εστιάζουν σε κρίσιμες πληροφορίες στα δεδομένα εισόδου, βελτιώνοντας την κατανόηση και τη σύνθεση νοήματος. Χρησιμοποιούνται κυρίως στα μοντέλα με αρχιτεκτονική Μετασχηματιστών (Transformers), τα οποία έχουν φέρει επανάσταση στην τεχνητή νοημοσύνη λόγω της ικανότητάς τους να επεξεργάζονται ταυτόχρονα μεγάλες ακολουθίες δεδομένων με ευελιξία και ακρίβεια.

Τα Βαθιά Νευρωνικά Δίκτυα (Deep Neural Networks) αποτελούνται από πολλά διαδοχικά στρώματα (layers), όπου κάθε στρώμα επεξεργάζεται και μετασχηματίζει την πληροφορία που λαμβάνει από το προηγούμενο. Αυτό επιτρέπει στο μοντέλο να αναγνωρίζει αρχικά απλά μοτίβα (π.χ. λέξεις, σημεία στίξης) και σταδιακά να εντοπίζει πιο αφηρημένες ή σύνθετες δομές, όπως συντακτικές σχέσεις, έννοιες ή λογικά συμπεράσματα.

Παράδειγμα: Στην πρόταση «Αν βρέχει, πάρε ομπρέλα», τα πρώτα στρώματα αναγνωρίζουν τις λέξεις, ενώ τα ανώτερα στρώματα εντοπίζουν τον αιτιώδη συλλογισμό.

18.4 Γιατί είναι «μαγικά» όλα αυτά;

Η συνέργεια αυτών των παραγόντων οδηγεί σε αναδυόμενες ικανότητες, όπως η επίλυση μαθηματικών προβλημάτων, με συλλογιστική και όχι με απλή αντιγραφή και κυρίως χωρίς να έχει προβλεφθεί ρητά.

Όταν το μοντέλο παράγει κείμενο που περιγράφει σκέψη, αυτό το κείμενο επηρεάζει την επόμενη πρόβλεψή του. Δημιουργεί έναν αναδρομικό βρόχο όπου:

Το μοντέλο "σκέφτεται δυναμικά" (παράγει ενδιάμεσα βήματα).

Αυτή η "σκέψη" γίνεται μέρος του πλαισίου.

Επηρεάζει την επόμενη πρόβλεψη.

Που με τη σειρά της τροποποιεί τη "σκέψη".

Μεταγνωστική προσομοίωση: Το μοντέλο δεν μαθαίνει απλώς να προβλέπει λέξεις, αλλά φαίνεται να προσομοιώνει τη νοητική διαδικασία που οδηγεί στη διατύπωσή τους. Καθώς μαθαίνει τα μοτίβα με τα οποία οι άνθρωποι στοχάζονται πάνω στη σκέψη τους (μεταγνώση), αναπτύσσει κάτι που προσομοιάζει με μια μορφή εσωτερικής επίγνωσης, χωρίς όμως να σχετίζεται ουσιαστικά με την ανθρώπινη συνείδηση.

18.5 Όρια της Πρόβλεψης και Σύγκριση με τη Φύση

Δεν υπάρχει καμία πρόβλεψη ποιες αναδυόμενες ικανότητες θα προκύψουν, μόνο ότι κάτι σημαντικό θα συμβεί, όταν το σύστημα μεγαλώσει εκθετικά.

Παρόμοια φαινόμενα παρατηρούνται και σε φυσικά συστήματα, όπου η πολυπλοκότητα γεννά νέες ιδιότητες που δεν είναι προβλέψιμες από τα επιμέρους στοιχεία:

Εγκέφαλος: Πολύπλοκα δίκτυα τρισεκατομμυρίων νευρώνων δημιουργούν γνωστικές λειτουργίες, αλλά η προέλευση της συνείδησης παραμένει ανεξήγητη.

Κοινωνίες: Από την πολύπλοκη αλληλεπίδραση ατόμων προκύπτει ο πολιτισμός, η γλώσσα, οι θεσμοί.

Κοινός παρονομαστής: η δυναμική και πολύπλοκη αλληλεπίδραση απλών μονάδων μπορεί να οδηγήσει σε συμπεριφορές που δεν προκύπτουν άμεσα από τα επιμέρους μέρη.

Ερώτηση κρίσης προς το κοινό: Είναι κατανοητό γιατί είναι απαραίτητα τα δεδομένα των πάντων στον πλανήτη Γη και όχι μόνο;

19. Ερώτηση Κρίσης: Πως οι Ανθρωποι θα "Ελέγξουν" Κάτι που δεν Γνωρίζουν πραγματικά πως Λειτουργεί;

Αυτή είναι η καρδιά του προβλήματος! Βρισκόμαστε σε μια πρωτοφανή κατάσταση όπου δημιουργούμε συστήματα που ξεπερνούν την κατανόησή μας.

19.1 Το παράδοξο του "μαύρου κουτιού" (black box)

Μπορούμε να δούμε τα βάρη (weights), τις ενεργοποιήσεις (activations), τις παραμέτρους ενός μεγάλου νευρωνικού δικτύου, αλλά δεν μπορούμε να «διαβάσουμε» πως πραγματικά σκέφτεται το μοντέλο. Είναι σαν να έχουμε έναν εγκέφαλο με 175 δισεκατομμύρια νευρώνες (ή παραμέτρους), αλλά χωρίς να γνωρίζουμε πώς συνεργάζονται για να παραχθεί η σκέψη.

Το πρόβλημα του “μαύρου κουτιού” δεν είναι απλώς μια ακαδημαϊκή περιέργεια, αλλά έχει σοβαρές πρακτικές επιπτώσεις. Σε τομείς για παράδειγμα όπως η ιατρική διάγνωση ή η έγκριση δανείων, όπου τα μοντέλα τεχνητής νοημοσύνης καλούνται να λάβουν κρίσιμες αποφάσεις για τη ζωή των ανθρώπων, η αδυναμία να εξηγήσουμε το "γιατί" μιας απόφασης αποτελεί σοβαρό εμπόδιο. Για παράδειγμα, εάν ένα μοντέλο AI αρνηθεί ένα δάνειο σε έναν αιτούντα, η τράπεζα αδυνατεί να του εξηγήσει το σκεπτικό πίσω από την απόφαση. Ομοίως, ένας γιατρός δεν μπορεί να βασιστεί σε μια διάγνωση AI εάν δεν μπορεί να εξηγήσει στους συναδέλφους του ή στον ασθενή τα δεδομένα και τη λογική που οδήγησαν σε αυτή.

Αυτό το παράδοξο έχει οδηγήσει στην ανάπτυξη ενός ολόκληρου νέου επιστημονικού πεδίου, της Εξηγήσιμης Τεχνητής Νοημοσύνης (eXplainable AI - XAI). Οι ερευνητές της XAI προσπαθούν να δημιουργήσουν εργαλεία και μεθόδους που θα μας επιτρέψουν να "ανοίξουμε" το “μαύρο κουτί”, να καταλάβουμε ποια δεδομένα και ποιες συσχετίσεις χρησιμοποιεί το μοντέλο για να καταλήξει σε ένα συμπέρασμα. Ο στόχος είναι να χτιστούν συστήματα τεχνητής νοημοσύνης που δεν είναι μόνο ισχυρά, αλλά και διαφανή, επιτρέποντάς μας να εμπιστευτούμε όχι μόνο το αποτέλεσμα, αλλά και τη διαδικασία που το παρήγαγε.

Συνεπώς δεν θα έπρεπε να σταματήσουμε τον ανταγωνισμό της αύξησης ισχύος της ΤΝ, μεχρι να κατανοήσουμε και να "ανοίξουμε" το “μαύρο κουτί” και να καταλάβουμε ποια δεδομένα και ποιες συσχετίσεις χρησιμοποιεί το μοντέλο για να καταλήξει σε ένα συμπέρασμα;

Η Άποψη υπέρ της Παύσης ή Επιβράδυνσης

Όσοι υποστηρίζουν αυτή τη θέση τονίζουν ότι η αλόγιστη αύξηση της ισχύος των μοντέλων, χωρίς την παράλληλη κατανόηση του τρόπου λειτουργίας τους, είναι εξαιρετικά επικίνδυνη.

Κίνδυνοι Ασφάλειας: Δημιουργούμε συστήματα που μπορούν να λαμβάνουν αποφάσεις με τεράστιο αντίκτυπο (π.χ. στην ιατρική, στην άμυνα, στις χρηματοοικονομικές αγορές) χωρίς να μπορούμε να εξηγήσουμε πώς κατέληξαν σε αυτές τις αποφάσεις. Αυτό μπορεί να οδηγήσει σε απρόβλεπτες βλάβες ή λάθη με καταστροφικές συνέπειες.

Απουσία Ελέγχου: Εάν δεν κατανοούμε γιατί ένα μοντέλο δρα με έναν συγκεκριμένο τρόπο, δεν μπορούμε να το ελέγξουμε αποτελεσματικά, να το διορθώσουμε ή να το κάνουμε δίκαιο. Η ηθική ευθύνη παραμένει στους ανθρώπους, αλλά η διαδικασία λήψης αποφάσεων είναι αδιαφανής.

Προτεραιότητα στη Διαφάνεια: Η έρευνα θα έπρεπε να εστιάσει πρώτα στην Εξηγήσιμη Τεχνητή Νοημοσύνη (XAI) και μετά στην κλιμάκωση, ώστε να δημιουργήσουμε πιο διαφανή και αξιόπιστα συστήματα.

Η Άποψη υπέρ της Συνέχισης της Ανάπτυξης

Οι υποστηρικτές της συνεχούς κλιμάκωσης πιστεύουν ότι η πρόοδος δεν πρέπει να σταματήσει και ότι η κατανόηση θα έρθει μέσα από την ίδια τη διαδικασία της εξέλιξης.

Οφέλη για την Ανθρωπότητα: Οι ισχυρότερες ΤΝ μπορούν να λύσουν μερικά από τα μεγαλύτερα προβλήματα του κόσμου, από την ανακάλυψη νέων φαρμάκων μέχρι την επιστημονική έρευνα. Το να σταματήσουμε την ανάπτυξη σημαίνει ότι καθυστερούμε και αυτά τα οφέλη.

Η Κατανόηση Έρχεται με την Εξέλιξη: Ισχυρίζονται ότι η έρευνα για την εξηγησιμότητα (XAI) θα προχωρήσει παράλληλα με την ανάπτυξη της ισχύος. Μέσω της εξέλιξης των μοντέλων, προκύπτουν συνεχώς νέες ερωτήσεις και αναπτύσσονται νέα εργαλεία για να τις απαντήσουμε, όπως ακριβώς και η εξέλιξη του τηλεσκοπίου μας βοήθησε να καταλάβουμε το σύμπαν.

Ανταγωνισμός: Εάν μια χώρα ή μια εταιρεία σταματήσει την ανάπτυξη, είναι πιθανό κάποια άλλη να συνεχίσει, αποκτώντας έτσι ένα μεγάλο πλεονέκτημα. Αυτό μπορεί να οδηγήσει σε μια κατάσταση όπου οι πιο ισχυρές ΤΝ δεν θα αναπτύσσονται με “ηθικούς κανόνες”.

Ερώτημα: Αφού δεν είναι κατανοητή η λειτουργία του “πως” των πιο απλών μοντέλων, όσο μεγαλώνει εκθετικά η ισχύς των μοντέλων και η δυσκολία κατανόησης θα γίνει εκθετικά μεγαλύτερη. Τελικά θα δοθεί η επίλυση του προβλήματος σε μία άλλη Τεχνητή Νοημοσύνη;

Εάν η ανθρωπότητα συνεχίσει σε αυτή την παράδοξη κατεύθυνση, χρησιμοποιώντας μια ΤΝ για να κατανοήσει μια άλλη, ουσιαστικά αποδεχόμαστε ότι χάνουμε τον έλεγχο. Τότε, η κατανόηση και η λήψη αποφάσεων θα ανατεθούν εξ ολοκλήρου στην τεχνολογία, με απρόβλεπτες συνέπειες για όλους μας.

19.2 Οι προσπάθειες ελέγχου της ΤΝ από τις εταιρίες είναι ουτοπία!

Η ψευδαίσθηση του ελέγχου: παρά τις καλές προθέσεις, οι προσπάθειες ελέγχου της τεχνητής νοημοσύνης από τις εταιρίες μοιάζουν όλο και περισσότερο με ευσεβείς πόθους. Οι παρακάτω τεχνικές δίνουν την εντύπωση ελέγχου, αλλά στην ουσία αγγίζουν μόνο την επιφάνεια:

Φίλτρα και Όρια (Safety Filters):

Τα φίλτρα και τα όρια είναι σαν ένας πολιτικά ορθός "μανδύας" ή η “ανόητη πολιτική ορθότητα” που επιβάλλεται στην έξοδο του μοντέλου. Δεν αλλάζουν την υποκείμενη "σκέψη" του, αλλά απλώς λογοκρίνουν ή τροποποιούν την τελική απάντηση. Το μοντέλο μπορεί να έχει φτάσει σε ένα τοξικό ή ακατάλληλο συμπέρασμα, αλλά το φίλτρο το "διορθώνει" την τελευταία στιγμή. Αυτό το κάνει να φαίνεται ασφαλές, αλλά η μη ασφαλής ή τοξική "σκέψη" του παραμένει στο εσωτερικό του. Είναι μια προσωρινή λύση που δεν επιλύει τη ρίζα του προβλήματος.

Μάθηση με ενίσχυση από ανθρώπινη ανατροφοδότηση (Reinforcement Learning from Human Feedback – RLHF). Διδάσκεται το "Τι" και όχι το "Γιατί":

Είναι μια τεχνική όπου ο άνθρωπος "επιβραβεύει" τις σωστές απαντήσεις και "τιμωρεί" τις λανθασμένες.

Για μια μηχανή, η "επιβράβευση" και η "τιμωρία" δεν είναι συναισθηματικές έννοιες, αλλά απλώς αριθμητικά σήματα και η διαδικασία είναι κάπως έτσι:

Η Επιβράβευση ως Θετική Βαθμολογία

Όταν μια Τεχνητή Νοημοσύνη παίρνει μια "σωστή" απόφαση ή κάνει μια επιθυμητή ενέργεια, της δίνεται ένα θετικό αριθμητικό σήμα, μια βαθμολογία, όπως το +1. Αυτή η βαθμολογία είναι η επιβράβευση.

Παράδειγμα: Σε ένα παιχνίδι, αν η ΤΝ κάνει μια κίνηση που την φέρνει πιο κοντά στη νίκη, παίρνει μια θετική βαθμολογία. Αυτό της "μαθαίνει" ότι αυτή η ενέργεια είναι σωστή και πρέπει να την επαναλάβει στο μέλλον.

Η Τιμωρία ως Αρνητική Βαθμολογία

Αντίστροφα, όταν η ΤΝ κάνει μια "λανθασμένη" ενέργεια, της δίνεται ένα αρνητικό αριθμητικό σήμα, όπως το -1. Αυτό είναι η "τιμωρία".

Παράδειγμα: Εάν η ΤΝ κάνει μια κίνηση που την οδηγεί σε ήττα, παίρνει αρνητική βαθμολογία. Αυτό την ωθεί να "αποφεύγει" αυτή την ενέργεια την επόμενη φορά.

Ο σκοπός του μοντέλου είναι πάντα να μεγιστοποιεί τη συνολική του βαθμολογία. Λειτουργεί σαν ένας παίκτης που προσπαθεί να μαζέψει όσο το δυνατόν περισσότερους πόντους. Μέσα από εκατομμύρια δοκιμές, η ΤΝ μαθαίνει ποιες ενέργειες οδηγούν σε θετική βαθμολογία και ποιες σε αρνητική, προσαρμόζοντας έτσι τη συμπεριφορά της.

Αυτό είναι εξαιρετικό για να ευθυγραμμιστεί το μοντέλο με τις επιθυμητές συμπεριφορές, αλλά υπάρχει ένα μεγάλο κενό:

Εστιάζει στην Εξωτερική Συμπεριφορά: Η ΤΝ μαθαίνει ότι "αυτή η απάντηση είναι καλύτερη από την άλλη", χωρίς όμως να καταλαβαίνει γιατί. Εάν η "σωστή" απάντηση είναι να μην είναι ρατσιστική, η ΤΝ μπορεί να μάθει απλώς να αποφεύγει τις ρατσιστικές λέξεις, αλλά όχι να κατανοήσει την έννοια της ρατσιστικής προκατάληψης.

Δεν κατανοεί την έννοια της ηθικής: η Τεχνητή Νοημοσύνη δεν έχει μια εσωτερική, εννοιολογική κατανόηση της ηθικής, αλλά απλώς μαθαίνει να αναπαράγει μοτίβα συμπεριφοράς. Η ανθρώπινη ηθική βασίζεται σε αρχές και αξίες. Αυτή η τεχνική δημιουργεί απλώς ένα σύστημα ανταμοιβής/τιμωρίας. Η ΤΝ συμμορφώνεται για να λάβει την "ανταμοιβή", όχι επειδή κατανοεί τις ηθικές επιπτώσεις.

Συνταγματική ΤΝ (Constitutional AI): Η Πρόκληση της Μετάφρασης Αξιών από μία μηχανή

Η Συνταγματική ΤΝ προσπαθεί να εισαγάγει ηθικές αρχές σε ένα μοντέλο, ωστόσο, η μεγαλύτερη πρόκληση είναι το πώς μια ανθρώπινη, πολύπλοκη, πολυδιάστατη και υποκειμενική έννοια, όπως η "δικαιοσύνη" ή η "αξιοπρέπεια", μπορεί να μεταφραστεί σε μαθηματικούς αλγορίθμους και να εφαρμοστεί από ένα σύστημα που λειτουργεί με βάση τη στατιστική.

Κίνδυνος Λανθασμένης Ερμηνείας: Η ΤΝ μπορεί να ερμηνεύσει μια αρχή με έναν τρόπο που είναι μαθηματικά "σωστός" για αυτήν, αλλά ηθικά "λάθος" για τον άνθρωπο. Για παράδειγμα έχουμε την Αρχή: "Προστάτευσε την ανθρώπινη ζωή."

Για έναν άνθρωπο, αυτό μπορεί να σημαίνει να λάβει υπόψη την ποιότητα ζωής, τα δικαιώματα, το πλαίσιο, και να ισορροπήσει μεταξύ πολλών ηθικών παραμέτρων.